Hiệu suất của việc phân lớp bộ nhớ đệm Ceph như thế nào?

Giới thiệu:

Trong bài viết này, chúng tôi chia sẻ một bài kiểm tra chuẩn để chứng minh cách mà việc phân lớp bộ nhớ đệm Ceph có thể cải thiện hiệu suất của một bể HDD bằng cách thiết lập một lớp bộ nhớ đệm được hỗ trợ bởi một bể NVMe.

Ceph Cache Tier là gì và làm việc như thế nào

Lớp bộ nhớ cache Ceph cho phép sử dụng các thiết bị lưu trữ nhanh hơn như bộ nhớ cache cho các thiết bị chậm hơn. Việc này liên quan đến việc tạo ra một nhóm thiết bị lưu trữ nhanh/đắt tiền (như NVMe SSD) được cấu hình để hoạt động như một tầng bộ nhớ cache, và một nhóm thiết bị chậm/rẻ hơn (như HDD) được cấu hình để hoạt động như một tầng lưu trữ tiết kiệm. Lớp bộ nhớ cache lưu trữ dữ liệu được truy cập thường xuyên từ lớp hậu cấp và phục vụ yêu cầu đọc và ghi từ các khách hàng. Đại lý lưu trữ tầng đệm định kỳ xóa hoặc loại bỏ các đối tượng khỏi tầng đệm dựa trên một số chính sách cụ thể.

Bài thuyết trình về Ceph Cache Tier

Trong quá khứ, khi sử dụng ổ đĩa SSD SATA làm thiết bị lưu trữ cache, cải tiến hiệu suất khi sử dụng cache tiering không đáng kể. Ngày nay, giá thành của ổ đĩa NVMe SSD đã giảm rất nhiều so với vài năm trước, và hiệu suất của NVMe SSD nhanh hơn rất nhiều so với HDD. Chúng tôi muốn biết liệu việc sử dụng ổ đĩa NVMe SSD làm cache tier có thể giúp đỡ đáng kể cho một nhóm HDD hay không.

Để kiểm tra hiệu quả của lớp bộ nhớ đệm NVMe, chúng tôi đã thiết lập một bài kiểm tra để xem liệu lớp bộ nhớ đệm có cải thiện hiệu suất của một bể lưu trữ dựa trên HDD hay không.

Thiết lập Cluster

| Các máy chủ NVME | 3 x Ambedded Mars500 Ceph Appliances |

| Thông số kỹ thuật của mỗi thiết bị Mars 500 | |

| CPU | 1x Ampere Altra Arm 64-Core 3.0 Ghz |

| Bộ nhớ | 96 GiB DDR4 |

| Mạng | 2 cổng 25Gbps Mellanox ConnectX-6 |

| Ổ đĩa OSD | 8 x Micron 7400 960GB |

| Máy chủ HDD | 3 x Ambedded Mars400 Ceph Appliances |

| Thông số kỹ thuật của từng thiết bị Mars 400 | |

| CPU | 8 nút Quad-Cores Arm64 tốc độ 1.2 GHz |

| Bộ nhớ | 4GiB cho mỗi nút. Tổng cộng 32 GiB cho mỗi thiết bị |

| Mạng | 2 x 2.5Gbps cho mỗi nút. 2x đường lên 10 Gb qua switch trong khung máy. |

| Ổ đĩa OSD | 8 x ổ cứng Seagate Exos 6 TB |

Thông tin Cụm Ceph

- 24 x OSD trên ổ NVMe SSD (3x thiết bị Mars500 Ambedded)

- 24x OSD trên ổ HDD (3x thiết bị Mars400 Ambedded)

- Các máy chủ HDD và NVMe được đặt tại các gốc CRUSH riêng biệt.

Các Máy Khách Kiểm Tra

- 2 x máy chủ vật lý. 2x thẻ mạng 25Gb

- Mỗi máy chủ chạy 7x máy ảo (VMs).

- Mỗi VM có 4x nhân và 8 GB bộ nhớ

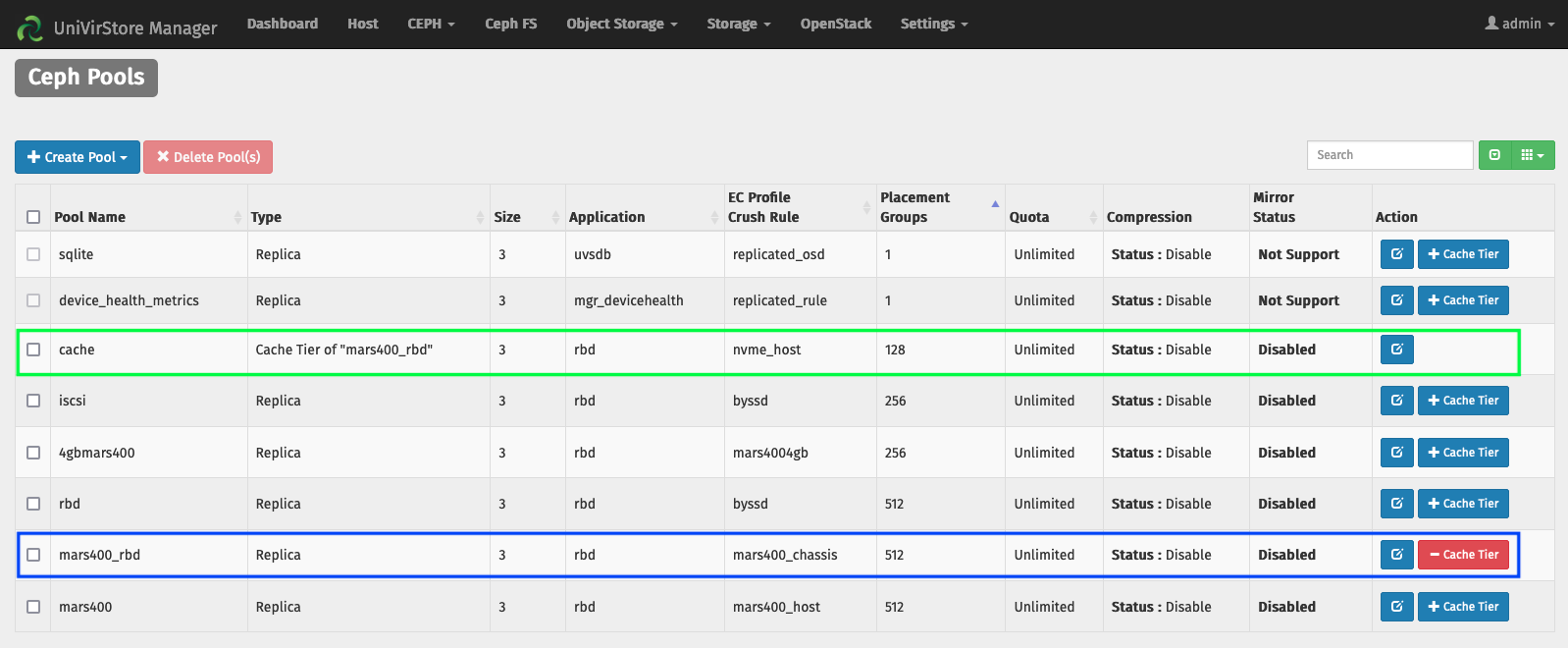

Thiết lập Cache Tier bằng trình quản lý UVS của Ambedded

1. Tạo một nhóm cơ sở bằng cách sử dụng ổ cứng HDD.

2. Tạo một nhóm NVMe sử dụng ổ đĩa NVMe SSD.

3. Thêm nhóm NVMe làm lớp cache của nhóm HDD.

cấu hình mặc định của lớp cache:

- Chế độ bộ nhớ cache: ghi lại sau

- hit_set_count = 12

- hit_set_period = 14400 giây (4 giờ)

- target_max_byte = 2 TiB

- target_max_objects = 1 triệu

- min_read_recency_for_promote & min_write_recency_for_promote = 2

- cache_target_dirty_ratio = 0.4

- cache_target_dirty_high_ratio = 0.6

- cache_target_full_ratio = 0.8

- cache_min_flush_age = 600 giây.

- cache_min_evict_age = 1800 giây.

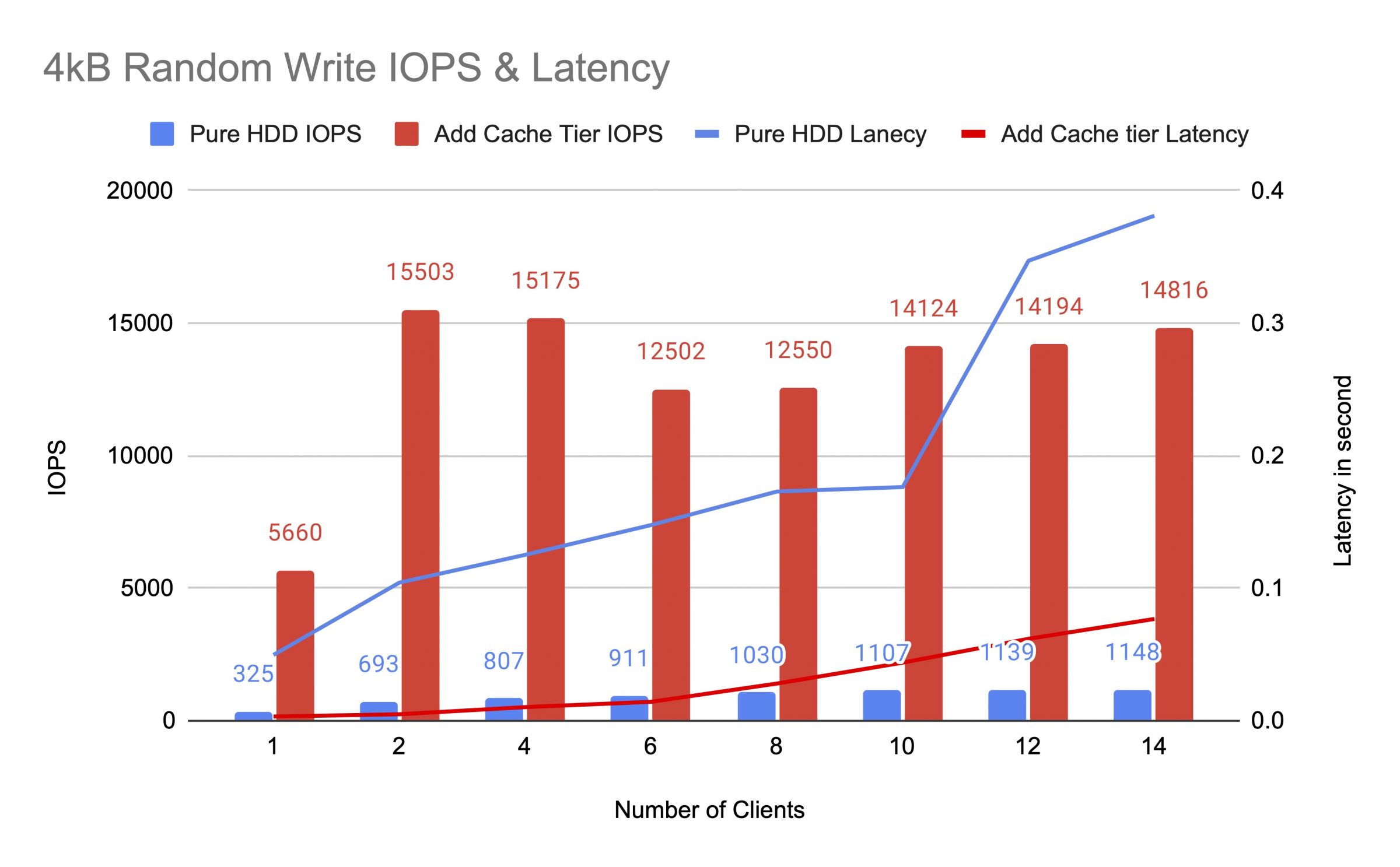

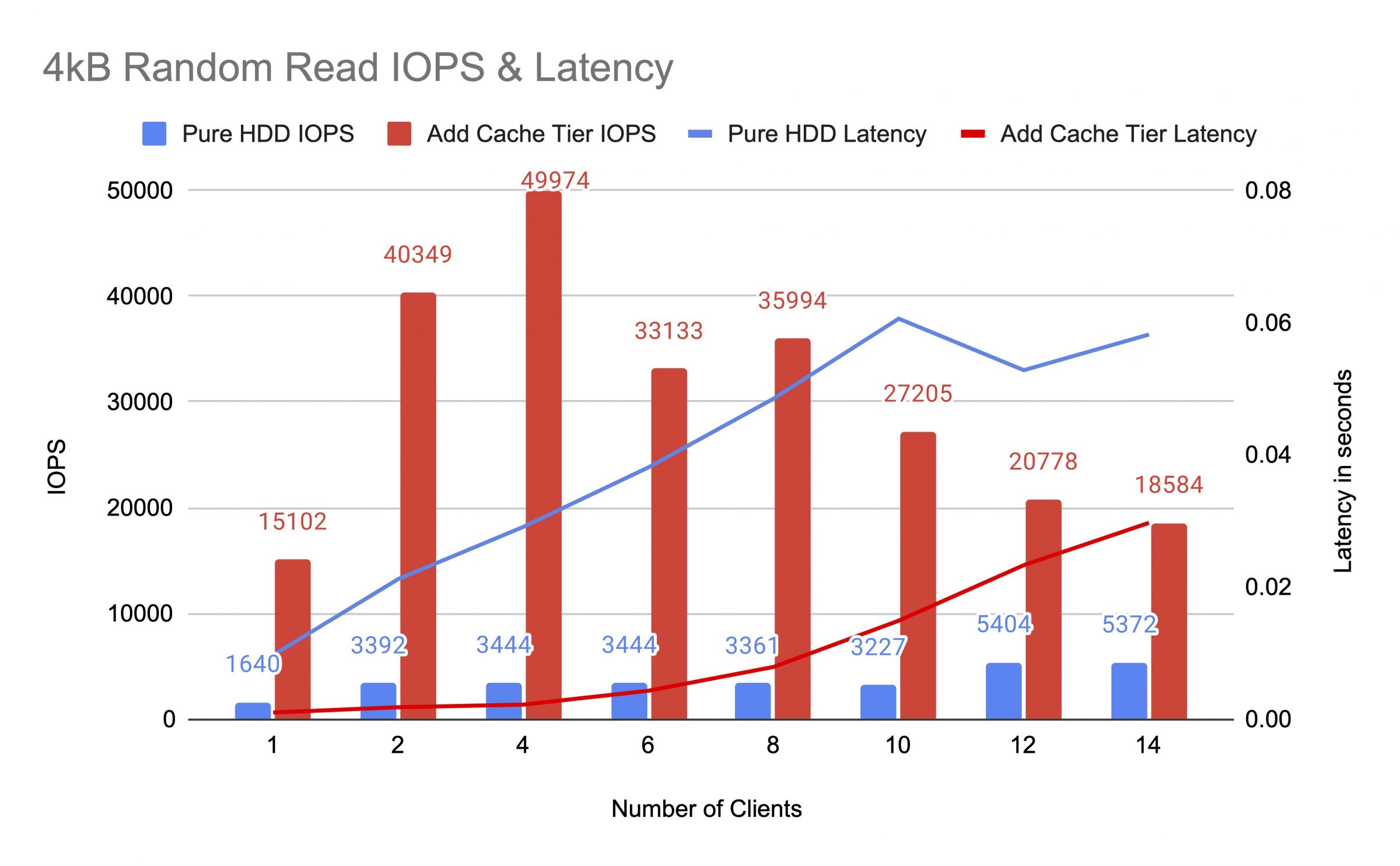

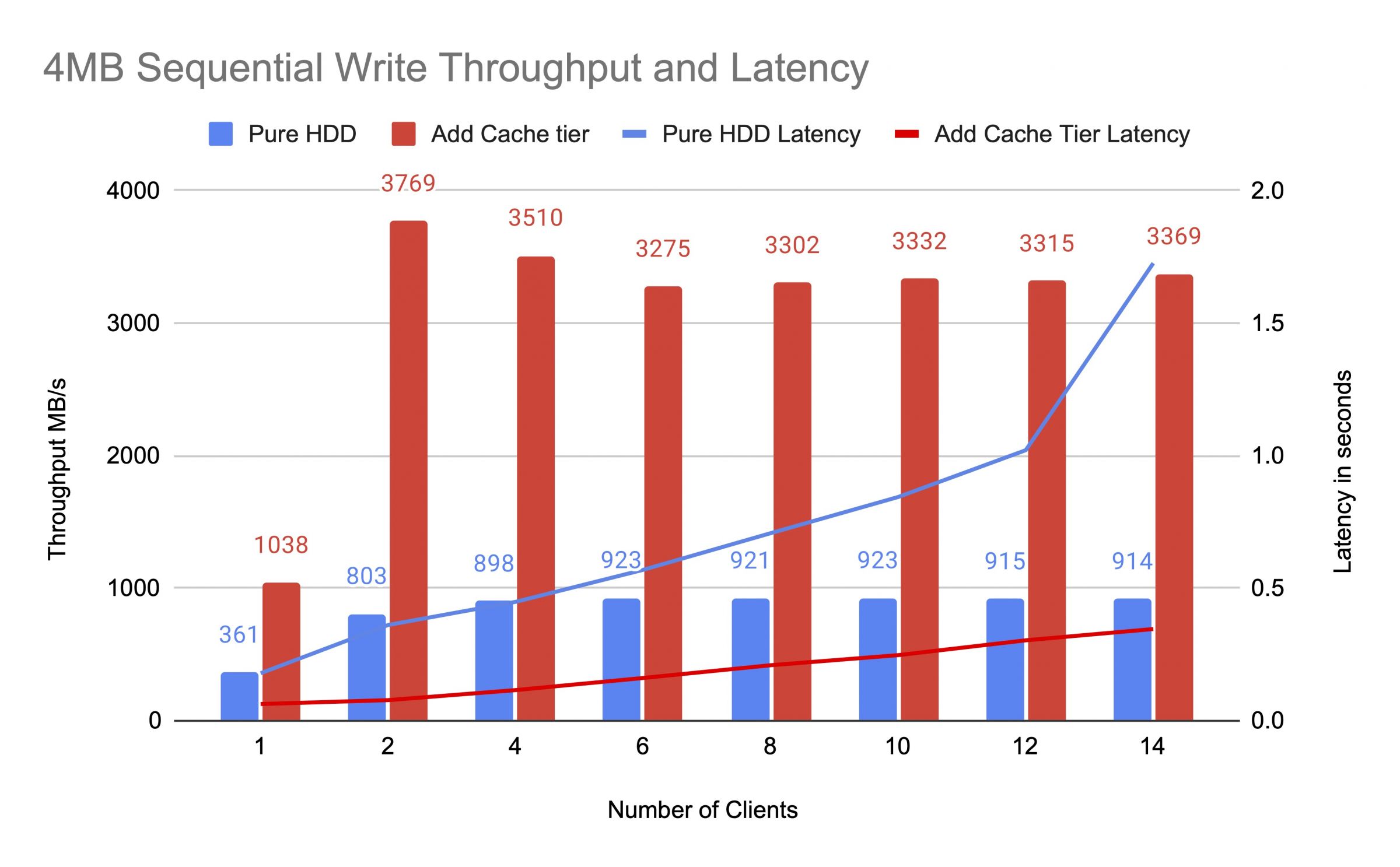

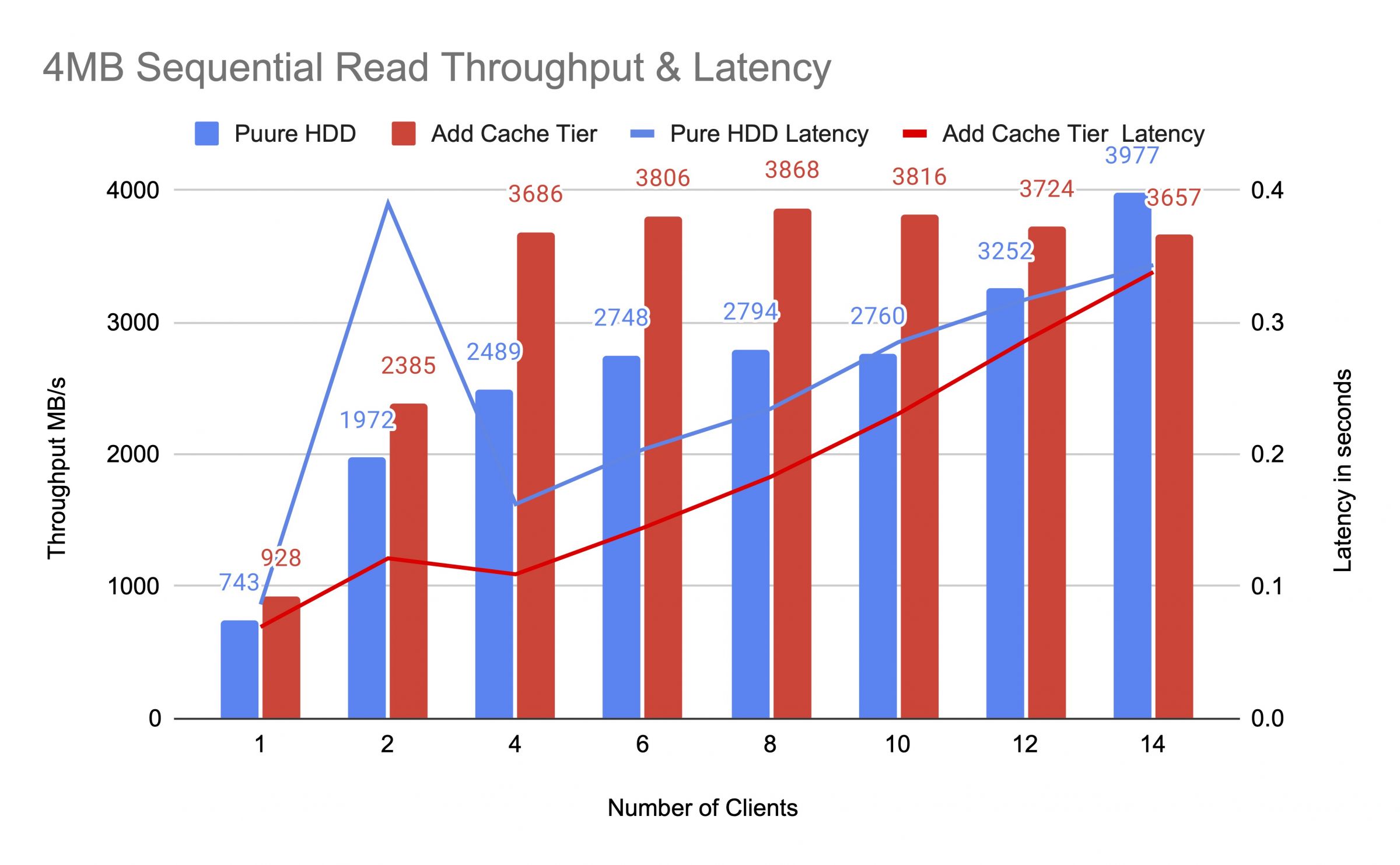

Chúng tôi đã kiểm tra nhóm HDD trước và sau khi thêm tầng bộ nhớ cache, sử dụng tối đa 14 khách hàng để tạo ra tải thử nghiệm. Mỗi khách hàng đã gắn một RBD cho bài kiểm tra fio. Quá trình kiểm tra bắt đầu với một khách hàng và tăng số lượng khách hàng sau khi mỗi công việc kiểm tra được hoàn thành. Mỗi chu kỳ kiểm tra kéo dài năm phút và được điều khiển tự động bởi Jenkins. Hiệu suất của một công việc kiểm tra là tổng của tất cả các kết quả của khách hàng. Trước khi kiểm tra lớp bộ nhớ cache, chúng tôi đã ghi dữ liệu vào RBDs cho đến khi hồ bơi lớp cache được lấp đầy vượt quá tỷ lệ đầy mục tiêu cache ceph (0.8).

Các biểu đồ cho thấy hiệu suất của bể HDD thuần túy đã được cải thiện đáng kể sau khi thêm bể cache NVMe.

Trong quá trình kiểm tra tầng bộ đệm, chúng tôi đã quan sát các chỉ số nhóm bằng cách sử dụng lệnh thống kê nhóm CEPH OSD. Bộ đệm và các nhóm cơ sở có hoạt động xả nước, trục xuất và thúc đẩy. Chúng tôi đã nắm bắt số liệu thống kê nhóm vào các thời điểm khác nhau trong quá trình kiểm tra cấp bộ đệm.

Dữ liệu đã được ghi vào bộ nhớ cache

Bể cache id 84

Tốc độ ghi của khách hàng là 21 MiB/s, không có hoạt động đọc, tốc độ ghi là 5.49k op/s

Bể mars400_rbd id 86

Không có hoạt động nào đang diễn ra

Bộ nhớ đệm đang thực hiện quảng bá và loại bỏ

pool bộ đệm id 84

client io 42 MiB/s wr, 0 op/s rd, 10,79k op/s wr

cấp bộ đệm io loại bỏ 179 MiB/giây, tăng 17 hoạt động/giây

pool mars400_rbd id 86

client io 0 B/s rd, 1,4 MiB/s wr, 18 op/s rd, 358 op/s wr

Bộ nhớ cache đang xả

\ npool ID ID 84

\ n Client IO 3.2 Gib/S Rd, 830 Op/S Rd, 0 Op/S WR

\ n Cache Cấp IO 238 MIB/S Flush, 14 OP/S quảng bá, 1 PGS

\ npool mars400_rbd id 86

\ n Client IO 126 MIB/S RD, 232 MIB/S WR, 44 OP/S RD, 57 OP/S WR

PG đã bị đuổi

pool bộ đệm id 84

client io 2,6 GiB/s rd, 0 B/s wr, 663 op/s rd, 0 op/s wr

cấp bộ đệm io xóa 340 MiB/s, trục xuất 2,7 MiB/s, thăng hạng 21 hoạt động/s, trục xuất 1 PG (đầy đủ)

pool mars400_rbd id 86

client io 768 MiB/s rd, 344 MiB/s wr, 212 op/s rd, 86 op/s wr

Đang xả PG và IO trực tiếp từ khách hàng vào pool cơ sở.(khách hàng đang ghi dữ liệu)

định danh bể cache 84

khách hàng io 0 B/s ghi, 0 op/s đọc, 1 op/s ghi

bể cache io 515 MiB/s xả, 7.7 MiB/s xóa, 1 PGs đang xả

định danh bể mars400_rbd 86

khách hàng io 613 MiB/s ghi, 0 op/s đọc, 153 op/s ghi

Sau khi thử nghiệm liên tục, chúng tôi đã nghỉ ngơi cụm trong vài giờ và thực hiện lại bài kiểm tra ghi ngẫu nhiên 4 kB. Chúng tôi đã đạt được hiệu suất tốt hơn nhiều. Điều này là do không gian bộ nhớ cache đã được giải phóng cho việc ghi mới.

Từ bài kiểm tra này, chúng tôi chắc chắn rằng việc sử dụng bể NVMe làm tầng bộ nhớ cache cho bể HDD có thể đạt được sự cải thiện hiệu suất đáng kể.

Cần lưu ý rằng hiệu suất của việc phân tầng bộ nhớ cache không thể được đảm bảo. Hiệu suất phụ thuộc vào điều kiện hit cache tại thời điểm đó, và hiệu suất tương tự không thể đạt được bằng cách lặp lại các bài kiểm tra với cùng một cấu hình và khối lượng công việc.

Nếu ứng dụng của bạn cần hiệu suất nhất quán, hãy sử dụng bể SSD NVMe thuần túy.

- Sản phẩm Liên quan

Thiết bị lưu trữ Ceph All Flash NVME Mars500

Mars 500

Thiết bị Ceph Mars 500 được thiết kế để đáp ứng nhu cầu lưu trữ dữ liệu đám mây hiệu suất cao. Nó sử dụng công...

Thông tin chi tiếtThiết bị lưu trữ Ceph Mars 400PRO

Mars 400PRO

Mars 400 Ceph Appliance được thiết kế để đáp ứng nhu cầu lưu trữ dữ liệu đám mây có dung lượng cao. Nó sử dụng ổ cứng...

Thông tin chi tiết