Veeam sao lưu và lưu trữ để làm việc với Ceph

Trường hợp nghiên cứu này giải thích cách sử dụng thiết bị lưu trữ Mars 400 ceph như các kho lưu trữ sao lưu của Veeam backup và replication.

Ceph hỗ trợ lưu trữ đối tượng, lưu trữ khối và hệ thống tệp POSIX trong cùng một cụm. Theo yêu cầu sao lưu, khách hàng có thể chọn các giao thức lưu trữ khác nhau để hỗ trợ các chiến lược sao lưu lưu trữ khác nhau.

Trong bài viết này, chúng tôi sử dụng lưu trữ khối Ceph (Ceph RBD) và hệ thống tệp Ceph (Cephfs) làm kho lưu trữ sao lưu và so sánh thời gian công việc sao lưu của chúng khi sao lưu máy ảo từ Hyper-V và VMWare.

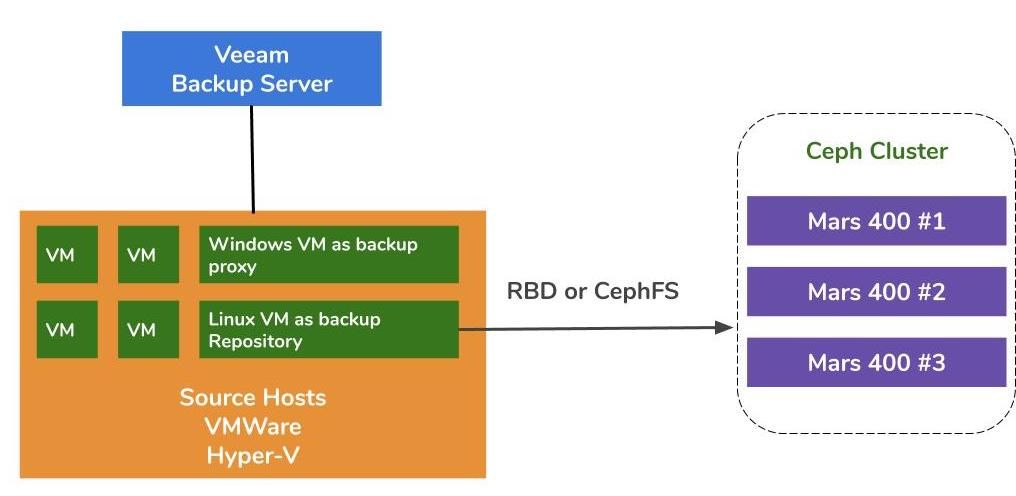

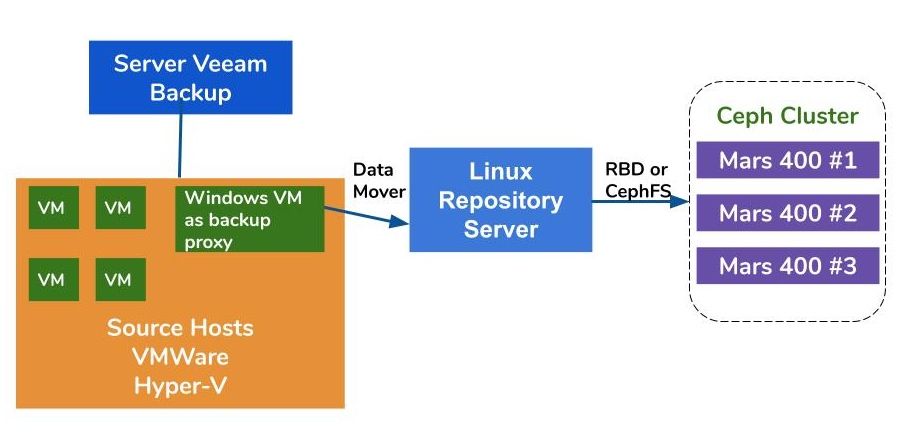

Kiến trúc Giải pháp Sao lưu bằng cách sử dụng Veeam và Ceph

Kiến trúc sao lưu máy ảo trên VMWare và Hyper-V tương tự nhau. Veeam sử dụng các công cụ di chuyển dữ liệu để chuyển dữ liệu từ máy chủ nguồn đến kho dự phòng. Các công cụ di chuyển dữ liệu chạy trên máy chủ proxy và máy chủ kho dự phòng. Để sử dụng Ceph làm lưu trữ phía sau của một kho dự phòng, bạn có thể gắn kết RBD hoặc CephFS trên một máy chủ vật lý hoặc máy ảo Linux làm máy chủ kho dự phòng.

Nếu các máy chủ proxy và kho lưu trữ là các máy ảo trong cụm hypervisor, bạn có thể tận dụng lợi ích của việc truyền dữ liệu tốc độ cao không qua mạng giữa ổ đĩa VM, máy chủ proxy và máy chủ kho lưu trữ. Cấu hình tốt nhất của một nhóm hypervisor lớn là triển khai một máy chủ proxy VM và một máy chủ kho VM trên mỗi máy chủ VMWare. Nếu không, bạn có thể triển khai một máy ảo proxy sao lưu trên mỗi máy chủ VMWare và một máy chủ kho lưu trữ ngoài để giảm công việc từ máy chủ VMWare sản xuất của bạn.

Có ba cách để sử dụng thiết bị Ceph Ambedded làm kho lưu trữ cho Sao lưu và sao chép Veeam.CephFS và thiết bị khối RBD có thể được sử dụng như kho lưu trữ sao lưu trên nơi đặt.Lưu trữ đối tượng S3 có thể được sử dụng làm tầng dung lượng cho một vị trí từ xa.

Để cấu hình thiết bị khối Ceph RBD và hệ thống tệp CephFS làm kho lưu trữ sao lưu của Veeam để sao lưu máy ảo và tệp tin, bạn có thể tìm thấy chi tiết trong bài báo trắng ở cuối trang này.

Môi trường kiểm tra

- Ba Mars 400 với 3 màn hình, 20 OSD và 1 MDS (máy chủ dữ liệu siêu dữ liệu)

- Mỗi tiến trình Ceph chạy trên một máy chủ nhỏ Arm A72 hai nhân

- Hệ điều hành: CentOS 7

- Phần mềm Ceph: Nautilus 14.2.9 Arm64

- Mạng: 4x mạng 10Gb trên mỗi Mars 400

Veeam Backup & Replication 10, Phiên bản: 10.0.1.4854

Máy chủ sao lưu Veeam

- CPU: Intel Xeon E5-2630 2.3GHz DUAL

- DRAM: 64GB

- Mạng: 2x 10Gb sfp+ kết nối

- Đĩa: 1TB cho hệ thống, ổ SSD SATA3 256GB cho dung lượng

- Windows Server 2019

Máy chủ Proxy Veeam

- đặt cùng với Máy chủ Sao lưu Veeam

Máy chủ Kho lưu trữ

- Máy ảo

◇ CPU: 4 lõi 2.3GHz

◇ DRAM: 8GB

◇ Mạng: cầu nối

◇ Đĩa: 50GB đĩa ảo

◇ HĐH: CentOS 7.8.2003

- Máy chủ Baremetal

◇ CPU: Intel Xeon X5650 2.67GHz DUAL

◇ DRAM: 48GB

◇ Mạng: 2 cổng 10Gb sfp+ kết nối

◇ Đĩa: 1TB cho hệ thống

◇ HĐH: CentOS 7.6.1810

Máy chủ Hyper-V

◇ CPU: Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM: 64GB

◇ Mạng: Kết nối 2 cổng 10Gb sfp+

◇ Ổ đĩa: 1TB cho hệ thống

◇ Máy chủ Windows 2019

Máy chủ VMWare

◇ CPU: Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM: 64GB

◇ Mạng: Kết nối 2 cổng 10Gb sfp+

◇ Ổ đĩa: 1TB cho hệ thống

◇ ESXi 6.5

Mạng: Switch 10GbE

Đánh giá trên các thiết lập khác nhau

Để đánh giá hiệu suất sao lưu của các kho lưu trữ sao lưu khác nhau, chúng tôi thiết lập các bài kiểm tra với các kho lưu trữ sao lưu khác nhau và ba nguồn sao lưu.

Các nguồn sao lưu mà chúng tôi sử dụng cho các bài kiểm tra là một ổ đĩa dựa trên SATA SSD trên một máy chủ, một máy ảo Windows của Hyper-V và một máy ảo CentOS 7 và một máy ảo Windows của VMWare.

(1) Sao lưu một ổ đĩa trên ổ cứng SSD

Bảng 1. Sao lưu một ổ đĩa từ máy chủ với SATA SSD.

| Kích thước ổ đĩa (Dữ liệu được xử lý) | 237.9GB |

| Dữ liệu đọc từ nguồn | 200.1GB |

| Dữ liệu được chuyển đến Ceph sau khi được giảm trùng và nén | 69.7GB |

| Giảm trùng | 1.3X |

| Nén | 2.7X |

Bảng 2.

|

Sao lưu Kho dữ liệu |

Thời gian (giây) |

Nguồn (%) |

Đại lý trung gian (%) |

Mạng lưới (%) |

Đích (%) |

Quá trình Tốc độ (MB/giây) |

Trung bình Viết dữ liệu Tốc độ (MB/giây) |

|

Máy ảo Linux, RBD-sao lưu 3 | 646 | 83 | 33 | 84 | 21 | 554 | 110 |

|

Máy ảo Linux, CephFS-sao lưu 3 | 521 | 97 | 25 | 31 | 5 | 564 | 137 |

|

Máy ảo Linux, RBD, EC | 645 | 82 | 34 | 83 | 24 | 554 | 111 |

|

Máy ảo Linux, CephFS, EC | 536 | 97 | 26 | 27 | 4 | 564 | 133 |

|

Máy chủ Linux, RBD, EC | 526 | 97 | 21 | 16 | 3 | 561 | 136 |

Lưu ý: Tỷ lệ Ghi Dữ liệu Trung bình được tính bằng cách chia Dữ liệu Truyền đi cho Thời gian. Những tỷ lệ này đại diện cho khối lượng công việc của cụm Ceph trong các công việc sao lưu này.

(2) Sao lưu một máy ảo Windows 10 trên Hyper-V trên ổ cứng

Trong bài đánh giá này, chúng tôi sao lưu một phiên bản Hyper-V được lưu trữ trên ổ cứng SATA. Tốc độ xử lý của những công việc này đạt đến giới hạn trên băng thông HDD. Chúng ta cũng có thể tìm thấy điểm chặn ở nguồn gốc vì tải của họ bận rộn trong 99% thời gian công việc. Cụm Ceph, mục tiêu, công việc từ các công việc sao lưu Veeam nhẹ nhàng. Cụm Ceph chỉ bận rộn ở mức từ 6% đến 1% trong thời gian làm việc.

So với bộ tiêu chuẩn trước đó, tốc độ xử lý sao lưu VM thấp hơn rất nhiều so với sao lưu SSD.Điều này chủ yếu là do dữ liệu VM được lưu trữ trên ổ cứng.

Bảng 3.

| Kích thước ổ đĩa (HDD) | 127GB |

| Dữ liệu đọc từ nguồn | 37.9GB |

| Dữ liệu đã được chuyển đến Ceph sau Quá trình giảm trùng và nén | 21.4GB |

| Giảm trùng | 3.3X |

| Nén | 1.8X |

Bảng 4. Sao lưu hình ảnh máy ảo trên ổ cứng SATA3

|

Sao lưu Kho dữ liệu |

Thời gian (giây) |

Nguồn (%) |

Đại lý trung gian (%) |

Mạng lưới (%) |

Đích (%) |

Quá trình Tốc độ (MB/giây) |

Trung bình Viết dữ liệu Tốc độ (MB/giây) |

|

Máy ảo Linux, Khối lượng RBD, EC | 363 | 99 | 7 | 3 | 6 | 145 | 60 |

|

Máy ảo Linux, Khối lượng CephFS, EC | 377 | 99 | 7 | 2 | 1 | 142 | 58.1 |

|

Máy chủ Linux, Khối lượng RBD, EC | 375 | 99 | 6 | 2 | 2 | 140 | 58.4 |

Lưu ý: Tỷ lệ Ghi Dữ liệu Trung bình được tính bằng cách chia Dữ liệu Truyền đi cho Thời gian. Những tỷ lệ này đại diện cho khối lượng công việc của cụm Ceph trong các công việc sao lưu này.

(3)Sao lưu máy ảo trên ESXi trên ổ cứng

Bài kiểm tra này sao lưu các máy ảo CentOS 7 và Windows 10 đang chạy trên ổ cứng của máy chủ VMWare ESXi 6.5 vào một kho dự phòng được hỗ trợ bởi Ceph RBD với bảo vệ mã lỗi 4+2.

Bảng 5.

| Nguồn | Máy ảo CentOS | Máy ảo Windows 10 |

| Kích thước ổ đĩa (HDD) | 40GB | 32GB |

| Dữ liệu đọc từ nguồn | 1.8GB | 12.9GB |

| Dữ liệu đã được chuyển đến Ceph sau Quá trình giảm trùng và nén | 966MB | 7.7GB |

| Giảm trùng | 22.1X | 2.5X |

| Nén | 1.9X | 1.7X |

Bảng 6.

|

Sao lưu Nguồn |

Thời gian (giây) |

Nguồn (%) |

Đại lý trung gian (%) |

Mạng lưới (%) |

Đích (%) |

Quá trình Tốc độ (MB/giây) |

Trung bình Viết dữ liệu Tốc độ (MB/giây) |

| CentOS 7 | 122 | 99 | 10 | 5 | 0 | 88 | 8 |

| Windows 10 | 244 | 99 | 11 | 5 | 1 | 93 | 32 |

Lưu ý: Tỷ lệ Ghi Dữ liệu Trung bình được tính bằng cách chia Dữ liệu Truyền đi cho Thời gian. Những tỷ lệ này đại diện cho khối lượng công việc của cụm Ceph trong các công việc sao lưu này.

Kết luận

Theo kết quả kiểm tra, Ceph RBD và CephFS có hiệu suất tương tự nhau. Điều này phù hợp với kinh nghiệm của chúng tôi về tiêu chuẩn hiệu suất RBD và CephFS. So sánh các đặc điểm của CephFS và RBD, chúng có những ưu điểm và nhược điểm riêng. Nếu bạn cần triển khai nhiều máy chủ lưu trữ kho dự án, bạn phải tạo một hình ảnh RBD cho mỗi máy chủ lưu trữ sao lưu vì bạn chỉ có thể gắn kết Ceph RBD trên một máy chủ. So với CephFS, việc sử dụng RBD đơn giản hơn vì nó không cần các máy chủ dữ liệu. Chúng ta phải gán kích thước dung lượng RBD khi tạo, vì vậy bạn phải thay đổi kích thước dung lượng khi bạn cần thêm không gian.

Nếu bạn sử dụng CephFS như một kho lưu trữ, bạn phải triển khai ít nhất một máy chủ dữ liệu siêu (MDS) trong cụm Ceph. Chúng ta cũng cần một máy chủ dữ liệu siêu dự phòng để đảm bảo tính sẵn có cao. So với Ceph RBD, bạn không cần đặt giới hạn cho hệ thống tệp. Vì vậy, bạn có thể coi CephFS như một hồ bơi lưu trữ không giới hạn.

Trong trường hợp sử dụng này, các bài kiểm tra của chúng tôi chỉ sao lưu một máy ảo trong mỗi công việc sao lưu. Theo các báo cáo kiểm tra trên, chúng tôi biết tỷ lệ ghi dữ liệu trung bình liên quan đến tỷ lệ xử lý và hiệu suất giảm trùng và nén dữ liệu. Ổ đĩa nguồn nhanh hơn giảm thiểu thời gian công việc sao lưu và dẫn đến tỷ lệ xử lý nhanh hơn. Tùy thuộc vào cơ sở hạ tầng của người dùng, người dùng có thể triển khai nhiều công việc đồng thời để sao lưu các đối tượng khác nhau cùng một lúc. Lưu trữ Ceph hoạt động rất tốt trong việc hỗ trợ nhiều công việc đồng thời.

Một cụm Ceph OSD HDD 20x được cung cấp bởi 3x Ambedded Mars 400 có thể cung cấp tốc độ ghi tổng hợp lên đến 700MB/s cho bể mã hóa 4+2. Triển khai nhiều công việc sao lưu hiện tại mang lại lợi ích giảm thời gian sao lưu tổng thể. Hiệu suất tối đa của một cụm Ceph gần như tuyến tính tỷ lệ với tổng số ổ đĩa trong cụm.

Trong trường hợp sử dụng này, chúng tôi không thử nghiệm việc sử dụng lưu trữ đối tượng S3 như một kho lưu trữ sao lưu. Lưu trữ đối tượng S3 có thể được sử dụng như một tầng dung lượng trong kho lưu trữ sao lưu Veeam Scale-Out và kho lưu trữ lưu trữ mục tiêu cho sao lưu NAS. Bạn có thể dễ dàng thiết lập một RADOS gateway và tạo người dùng lưu trữ đối tượng dễ dàng bằng cách sử dụng Ambedded UVS manager, giao diện web quản lý ceph.

- Tải xuống

Sử dụng Ceph làm kho lưu trữ cho tài liệu trắng Veeam Backup & Replication

Cách thiết lập thiết bị khối Ceph RBD và hệ thống tệp CephFS làm kho lưu trữ sao lưu của Veeam để sao lưu máy ảo và tệp

Tải xuống- Sản phẩm Liên quan

Thiết bị lưu trữ Ceph Mars 400PRO

Mars 400PRO

Mars 400 Ceph Appliance được thiết kế để đáp ứng nhu cầu lưu trữ dữ liệu đám mây có dung lượng cao. Nó sử dụng ổ cứng...

Thông tin chi tiết