Veeam zálohování a archivace pro práci s Ceph

Tato studie případu vysvětluje, jak používat úložný systém Mars 400 ceph jako zálohovací úložiště pro zálohování a replikaci Veeam.

Ceph podporuje objektové úložiště, blokové úložiště a souborový systém POSIX v jednom clusteru. Podle požadavků na zálohování si zákazníci mohou vybrat různé úložné protokoly, které podporují potřeby různých strategií zálohování úložiště.

V tomto článku používáme Ceph blokové úložiště (Ceph RBD) a Ceph souborový systém (Cephfs) jako zálohovací úložiště a porovnáváme dobu trvání zálohovacích úloh při zálohování virtuálních strojů z Hyper-V a VMWare.

Architektura zálohovacího řešení pomocí Veeam a Ceph

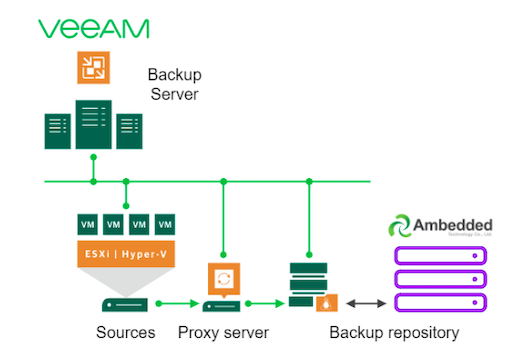

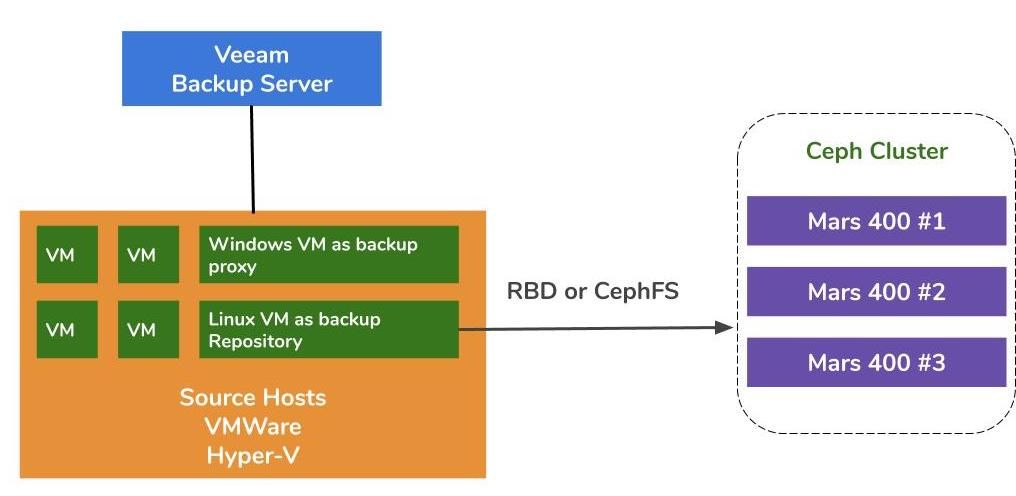

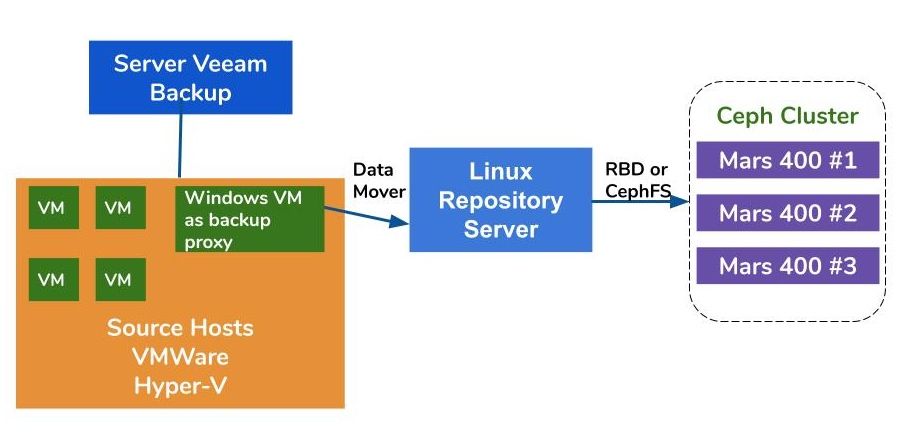

Architektura zálohování virtuálních strojů na VMWare a Hyper-V je podobná. Veeam používá datové přesunovače k přenosu dat ze zdrojových hostitelů do zálohovacích repozitářů. Datové přesunovače běží na proxy serveru a serveru repozitáře. Pro použití Ceph jako pozadí pro zálohovací repozitář můžete připojit RBD nebo CephFS na fyzický nebo virtuální Linuxový server jako server repozitáře.

Pokud jsou proxy a repozitářové servery virtuální stroje uvnitř klastru hypervizoru, můžete využít bezproblémového přenosu dat vysokou rychlostí mezi diskem virtuálního stroje, proxy serverem a repozitářovým serverem. Nejlepší konfigurace velkého hypervizorového clusteru je nasadit jeden proxy server VM a jeden repozitářový server VM na každý VMWare host. Alternativně můžete nasadit jednu záložní proxy VM na každý VMWare host a jednoho hosta mimo hostitele úložiště, abyste snížili zátěž na vašem produkčním VMWare.

Existují tři způsoby, jak použít Ambedded Ceph appliance jako úložiště pro Veeam Backup and Replication.CephFS a RBD bloková zařízení lze použít jako záložní úložiště na místě.Úložiště objektů S3 lze použít jako kapacitní vrstvu pro vzdálenou lokalitu.

Podrobnosti o tom, jak nastavit blokové zařízení Ceph RBD a souborový systém CephFS jako záložní repozitář Veeam pro zálohování virtuálních strojů a souborů, najdete v bílé knize na konci této stránky.

Testovací prostředí

Seskupení Ceph

- Tři Mars 400 s 3x monitory, 20 OSD a 1x MDS (server pro metadata)

- Každý démon Ceph běží na jednom dvoujádrovém mikroserveru Arm A72

- Operační systém: CentOS 7

- Software Ceph: Nautilus 14.2.9 Arm64

- Síť: 4x 10Gb síť pro každý Mars 400

Veeam Záloha & Replikace 10, Verze: 10.0.1.4854

Server pro zálohu Veeam

- CPU: Intel Xeon E5-2630 2.3GHz DUAL

- DRAM: 64GB

- Síť: 2x 10Gb sfp+ svázání

- Disk: 1TB pro systém, 256GB SATA3 SSD pro úložiště

- Windows Server 2019

Veeam Proxy Server

- umístěte vedle Veeam Záložního Serveru

Server pro úložiště

- Virtuální stroj

◇ CPU: 4 jádra 2.3GHz

◇ DRAM: 8GB

◇ Síť: most

◇ Disk: 50GB virtuální disk

◇ OS: CentOS 7.8.2003

- Server na holém kovu

◇ CPU: Intel Xeon X5650 2.67GHz DUAL

◇ DRAM: 48GB

◇ Síť: 2-port 10Gb sfp+ svazek

◇ Disk: 1TB pro systém

◇ OS: CentOS 7.6.1810

Hostitel Hyper-V

◇ CPU: Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM: 64GB

◇ Síť: 2-portové 10Gb sfp+ sdružování

◇ Disk: 1TB pro systém

◇ Windows Server 2019

Hostitel VMWare

◇ CPU: Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM: 64GB

◇ Síť: 2-portové 10Gb sfp+ sdružování

◇ Disk: 1TB pro systém

◇ ESXi 6.5

Síť: 10GbE přepínač

Benchmark na různých nastaveních

Pro benchmark zálohovacího výkonu různých zálohovacích úložišť jsme provedli testy s různými zálohovacími úložišti a třemi zálohovými zdroji.

Zálohové zdroje, které jsme použili pro testy, jsou založeny na SATA SSD disku na serveru, Windows VM na Hyper-V a CentOS 7 VM a Windows VM na VMWare.

(1) Zálohování objemu na SSD disku

Tabulka 1. Zálohování objemu ze serveru s SATA SSD.

| Velikost disku (zpracovaná data) | 237,9 GB |

| Přečtená data ze zdroje | 200,1 GB |

| Data přenesena do Ceph po deduplikaci a kompresi | 69,7 GB |

| Deduplikace | 1,3X |

| Kompresce | 2,7X |

Tabulka 2.

|

Záloha Úložiště |

Trvání (sek) |

Zdroj (%) |

Proxy (%) |

Síť (%) |

Cílový (%) |

Zpracování Rychlost (MB/s) |

Průměrný Zápis dat Rychlost (MB/s) |

|

Linuxová virtuální stroj, RBD-replika 3 | 646 | 83 | 33 | 84 | 21 | 554 | 110 |

|

Linuxová virtuální stroj, CephFS-replika 3 | 521 | 97 | 25 | 31 | 5 | 564 | 137 |

|

Linuxová virtuální stroj, RBD, EC | 645 | 82 | 34 | 83 | 24 | 554 | 111 |

|

Linuxová virtuální stroj, CephFS, EC | 536 | 97 | 26 | 27 | 4 | 564 | 133 |

|

Linux Server, RBD, EC | 526 | 97 | 21 | 16 | 3 | 561 | 136 |

Poznámka: Průměrné rychlosti zápisu dat jsou vypočítány jako podíl přenesených dat a trvání. Tyto rychlosti představují pracovní zatížení klastru Ceph v těchto zálohovacích úlohách.

(2) Zálohování virtuálního stroje s Windows 10 na Hyper-V na HDD

V tomto testu zálohujeme instanci Hyper-V, která je uložena na pevném disku SATA. Zpracovatelské rychlosti těchto úkolů dosahují horního limitu šířky pásma HDD. Také můžeme zjistit, že úzkým hrdlem je zdroj, protože jejich zatížení je během 99% trvání úkolu vytížené. Ceph cluster, cíl, zátěž z Veeam zálohovacích úloh je lehká. Cluster Ceph je zaneprázdněný pouze 6% až 1% pracovní doby.

Ve srovnání s předchozím měřením je rychlost zpracování záloh virtuálních strojů mnohem nižší než u záloh na SSD.To je především z důvodu, že data virtuálního stroje jsou uložena na pevném disku.

Tabulka 3.

| Velikost disku (HDD) | 127GB |

| Čtení dat ze zdroje | 37.9GB |

| Data přenesena do Ceph po Deduplikace a komprese | 21,4 GB |

| Deduplikace | 3,3X |

| Kompresce | 1,8X |

Tabulka 4. Zálohování obrazu virtuálního stroje na SATA3 HDD

|

Záloha Úložiště |

Trvání (sek) |

Zdroj (%) |

Proxy (%) |

Síť (%) |

Cílový (%) |

Zpracování Rychlost (MB/s) |

Průměrný Zápis dat Rychlost (MB/s) |

|

Linuxová virtuální stroj, RBD objem, EC | 363 | 99 | 7 | 3 | 6 | 145 | 60 |

|

Linuxová virtuální stroj, CephFS objem, EC | 377 | 99 | 7 | 2 | 1 | 142 | 58.1 |

|

Linux Server, RBD objem, EC | 375 | 99 | 6 | 2 | 2 | 140 | 58.4 |

Poznámka: Průměrné rychlosti zápisu dat jsou vypočítány jako podíl přenesených dat a trvání. Tyto rychlosti představují pracovní zatížení klastru Ceph v těchto zálohovacích úlohách.

(3)Zálohování virtuálních strojů na ESXi na HDD

Tento test zálohování zálohuje virtuální stroje CentOS 7 a Windows 10 běžící na pevném disku hostitele VMWare ESXi 6.5 do repozitáře podporovaného Ceph RBD s ochranou erasure kódem 4+2.

Tabulka 5.

| Zdroj | CentOS VM | Windows 10 VM |

| Velikost disku (HDD) | 40GB | 32GB |

| Čtení dat ze zdroje | 1.8GB | 12.9GB |

| Data přenesena do Ceph po Deduplikace a komprese | 966MB | 7.7GB |

| Deduplikace | 22.1X | 2.5X |

| Kompresce | 1.9X | 1.7X |

Tabulka 6.

|

Záloha Zdroj |

Trvání (sek) |

Zdroj (%) |

Proxy (%) |

Síť (%) |

Cílový (%) |

Zpracování Rychlost (MB/s) |

Průměrný Zápis dat Rychlost (MB/s) |

| CentOS 7 | 122 | 99 | 10 | 5 | 0 | 88 | 8 |

| Windows 10 | 244 | 99 | 11 | 5 | 1 | 93 | 32 |

Poznámka: Průměrné rychlosti zápisu dat jsou vypočítány jako podíl přenesených dat a trvání. Tyto rychlosti představují pracovní zatížení klastru Ceph v těchto zálohovacích úlohách.

Závěry

Podle výsledků testu mají Ceph RBD a CephFS podobný výkon. Toto odpovídá našemu zkušenosti ohledně výkonnosti RBD a CephFS benchmarku. Při porovnávání vlastností CephFS a RBD mají své výhody i nevýhody. Pokud potřebujete nasadit více serverů pro ukládání repozitářů, musíte vytvořit RBD obraz pro každý server zálohovacího repozitáře, protože Ceph RBD lze připojit pouze k jednomu hostiteli. V porovnání s CephFS je použití RBD jednodušší, protože nepotřebuje metadata servery. Při vytváření musíme přiřadit velikost kapacity RBD, takže musíte změnit její kapacitu, když potřebujete více místa.

Pokud používáte CephFS jako úložiště, musíte nasadit alespoň jeden server metadat (MDS) v Ceph clusteru. Také potřebujeme záložní server metadat pro vysokou dostupnost. Ve srovnání s Ceph RBD nemusíte souborovému systému přidělovat kvótu. Takže můžete CephFS považovat za neomezený úložný bazén.

V této ukázkové demonstraci použití zálohujeme pouze jedno virtuální zařízení v každé zálohovací úloze. Podle výše uvedených testovacích zpráv víme, že průměrná rychlost zápisu dat souvisí s rychlostí zpracování a efektivitou deduplikace a komprese dat. Rychlejší zdrojový disk snižuje dobu trvání zálohovací úlohy a vede k rychlejší rychlosti zpracování. V závislosti na infrastruktuře uživatelů mohou uživatelé nasadit několik současných úloh pro zálohování různých objektů současně. Úložiště Ceph se velmi dobře osvědčuje při podpoře více současných úloh.

Ceph cluster s 20x HDD OSD poháněný 3x Ambedded Mars 400 může nabídnout až 700MB/s agregovaný zápisový průtok do 4+2 erasure code poolu. Nasazení více současných zálohovacích úloh přináší výhodu snížení celkové doby zálohování. Maximální výkon Ceph clusteru je téměř přímo úměrný celkovému počtu diskových jednotek v clusteru.

V tomto případě jsme neprováděli testování použití úložiště objektů S3 jako záložního úložiště. Úložiště objektů S3 lze použít jako kapacitní vrstvu v záložním úložišti Veeam Scale-Out a cílové archivní úložiště pro zálohování NAS. Snadno můžete nastavit bránu RADOS a snadno vytvářet uživatele úložiště objektů pomocí Ambedded UVS manageru, webového grafického rozhraní pro správu Ceph.

- Stáhnout

Použijte Ceph jako úložiště pro bílou knihu Veeam Backup & Replication

Jak nastavit blokové zařízení Ceph RBD a souborový systém CephFS jako záložní úložiště Veeam pro zálohování virtuálních strojů a souborů

Stažení- Související produkty

Úložné zařízení Ceph Mars 400PRO

Mars 400PRO

Mars 400 Ceph Appliance je navržen tak, aby splňoval vysoké kapacitní potřeby pro ukládání dat v cloudu. Využívá HDD pro výhodu nízké ceny...

Podrobnosti