Veeam 백업 및 아카이브를 Ceph와 함께 사용하기

이 사례 연구에서는 Mars 400 Ceph 스토리지 애플라이언스를 Veeam 백업 및 복제의 백업 저장소로 사용하는 방법을 설명합니다.

Ceph는 한 클러스터에서 객체 스토리지, 블록 스토리지 및 POSIX 파일 시스템을 모두 지원합니다. 백업 요구 사항에 따라 고객은 다양한 스토리지 백업 전략의 요구 사항을 지원하기 위해 다른 스토리지 프로토콜을 선택할 수 있습니다.

이 문서에서는 Ceph 블록 스토리지(Ceph RBD)와 Ceph 파일 시스템(Cephfs)을 백업 저장소로 사용하고, Hyper-V 및 VMWare에서 가상 머신을 백업하는 백업 작업 지속 시간을 비교합니다.

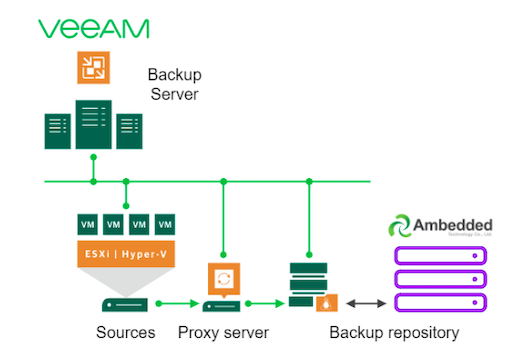

Veeam과 Ceph를 사용한 백업 솔루션 아키텍처

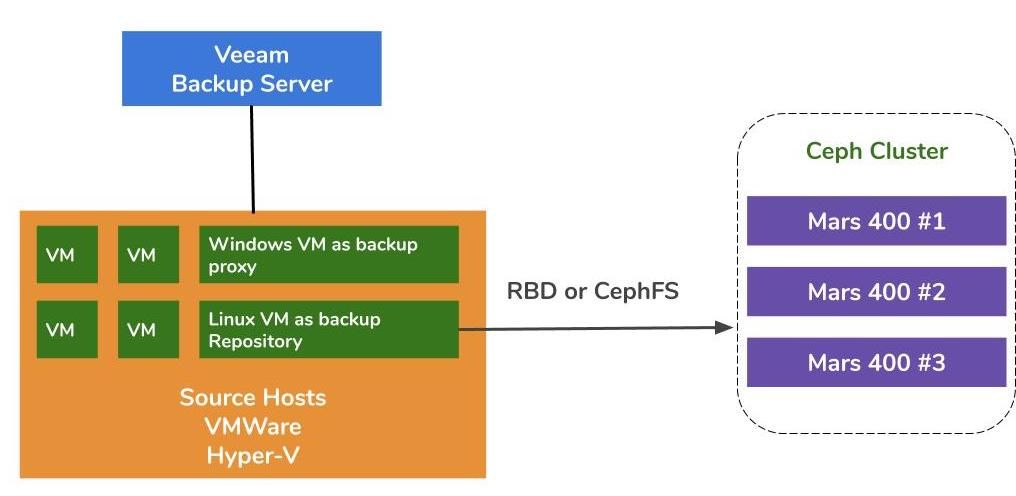

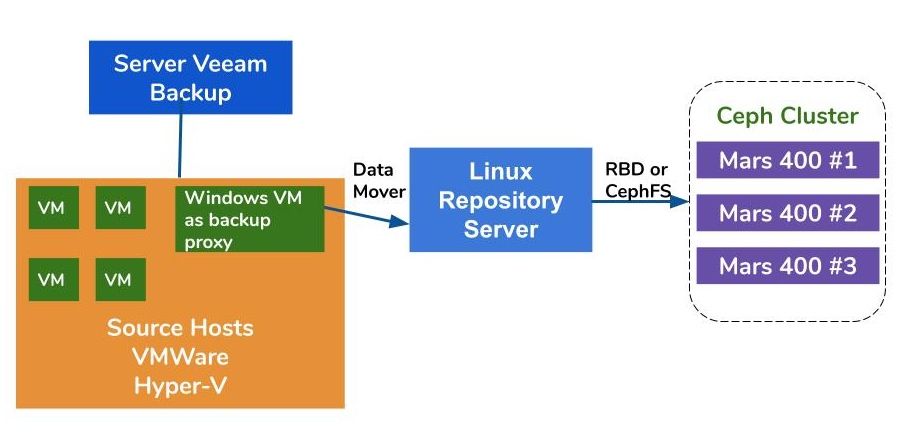

VMWare와 Hyper-V에서 가상 머신의 백업 아키텍처는 유사합니다. Veeam은 데이터 이동자를 사용하여 소스 호스트에서 백업 저장소로 데이터를 전송합니다. 데이터 이동자는 프록시 서버와 저장소 서버에서 실행됩니다. 백업 저장소의 백엔드 스토리지로 Ceph를 사용하려면 Linux 물리 서버나 가상 머신에 RBD 또는 CephFS를 마운트하여 저장소 서버로 사용할 수 있습니다.

프록시 및 저장소 서버가 하이퍼바이저 클러스터 내의 가상 머신인 경우, VM 디스크, 프록시 서버 및 저장소 서버 간에 네트워크 없이 고속 데이터 전송의 이점을 얻을 수 있습니다. 대형 하이퍼바이저 클러스터의 최적 구성은 각 VMWare 호스트에 하나의 프록시 서버 VM과 하나의 저장소 서버 VM을 배치하는 것입니다. 그렇지 않으면, 각 VMWare 호스트에 대해 하나의 백업 프록시 VM을 배포하고 하나의 오프-호스트 저장소 호스트를 배치하여 프로덕션 VMWare의 작업 부하를 제거할 수 있습니다.

Veeam Backup and Replication의 저장소로 Ambedded Ceph 어플라이언스를 사용하는 방법은 세 가지가 있습니다.CephFS과 RBD 블록 장치는 온프레미스 백업 저장소로 사용할 수 있습니다.S3 객체 스토리지를 원격 위치의 용량 계층으로 사용할 수 있습니다.

Ceph RBD 블록 장치 및 CephFS 파일 시스템을 Veeam의 백업 저장소로 설정하는 방법에 대한 자세한 내용은 이 페이지의 맨 끝에 있는 백서에서 찾을 수 있습니다.

테스트 환경

- 3개의 Mars 400, 3개의 모니터, 20개의 OSD 및 1개의 MDS(메타데이터 서버)

- 각 Ceph 데몬은 하나의 듀얼 코어 Arm A72 마이크로서버에서 실행됩니다.

- 운영 체제: CentOS 7

- Ceph 소프트웨어: Nautilus 14.2.9 Arm64

- 네트워크: Mars 400당 4개의 10Gb 네트워크

Veeam Backup & Replication 10, 버전: 10.0.1.4854

Veeam 백업 서버

- CPU: 인텔 제온 E5-2630 2.3GHz 듀얼

- DRAM: 64GB

- 네트워크: 2x 10Gb sfp+ 본딩

- 디스크: 시스템용 1TB, 볼륨용 256GB SATA3 SSD

- 윈도우 서버 2019

Veeam 프록시 서버

- Veeam 백업 서버와 공유 위치

리포지토리 서버

- 가상 머신

◇ CPU: 4 코어 2.3GHz

◇ DRAM: 8GB

◇ 네트워크: 브리지

◇ 디스크: 50GB 가상 디스크

◇ 운영체제: CentOS 7.8.2003

- 베어메탈 서버

◇ CPU: 인텔 제온 X5650 2.67GHz 듀얼

◇ DRAM: 48GB

◇ 네트워크: 2포트 10Gb sfp+ 본딩

◇ 디스크: 1TB 시스템용

◇ 운영체제: CentOS 7.6.1810

하이퍼-V 호스트

◇ CPU: Intel Xeon E5-2630 2.3GHz 듀얼

◇ DRAM: 64GB

◇ 네트워크: 2포트 10Gb sfp+ 본딩

◇ 디스크: 시스템용 1TB

◇ 윈도우 서버 2019

VMWare 호스트

◇ CPU: Intel Xeon E5-2630 2.3GHz 듀얼

◇ DRAM: 64GB

◇ 네트워크: 2포트 10Gb sfp+ 본딩

◇ 디스크: 시스템용 1TB

◇ ESXi 6.5

네트워크: 10GbE 스위치

다양한 설정에서의 벤치마크

다양한 백업 저장소의 백업 성능을 벤치마크하기 위해, 우리는 다른 백업 저장소와 세 개의 백업 소스로 테스트를 설정했습니다.

테스트에 사용되는 백업 소스는 서버의 SATA SSD 기반 볼륨, Hyper-V의 Windows 가상 머신, 그리고 CentOS 7 가상 머신과 VMWare의 Windows 가상 머신입니다.

(1) SSD 드라이브의 볼륨 백업

표 1. SATA SSD가 장착된 서버의 볼륨 백업.

| 디스크 크기 (데이터 처리량) | 237.9GB |

| 소스에서 읽은 데이터 | 200.1GB |

| 중복 제거 및 압축 후 Ceph로 데이터 전송 완료 | 69.7GB |

| 중복 제거 | 1.3배 |

| 압축 | 2.7배 |

표 2.

|

백업 저장소 |

지속 시간 (초) |

원본 (%) |

프록시 (%) |

네트워크 (%) |

대상 (%) |

처리 중 속도 (MB/s) |

평균 데이터 쓰기 속도 (MB/s) |

|

리눅스 VM, RBD-레플리카 3 | 646 | 83 | 33 | 84 | 21 | 554 | 110 |

|

리눅스 VM, CephFS-레플리카 3 | 521 | 97 | 25 | 31 | 5 | 564 | 137 |

|

리눅스 VM, RBD, EC | 645 | 82 | 34 | 83 | 24 | 554 | 111 |

|

리눅스 VM, CephFS, EC | 536 | 97 | 26 | 27 | 4 | 564 | 133 |

|

리눅스 서버, RBD, EC | 526 | 97 | 21 | 16 | 3 | 561 | 136 |

참고: 평균 데이터 쓰기 속도는 전송된 데이터를 기간으로 나눈 값입니다. 이 속도는 백업 작업에서 Ceph 클러스터의 작업량을 나타냅니다.

(2) HDD에 Hyper-V에서 Windows 10 가상 머신 백업

이 벤치마크에서는 SATA 하드 드라이브에 저장된 Hyper-V 인스턴스를 백업합니다. 이 작업들의 처리 속도는 HDD 대역폭의 상한에 도달합니다. 우리는 또한 병목 현상이 소스에서 발생하는 것을 알 수 있습니다. 왜냐하면 작업 기간의 99% 동안 그들의 부하가 바쁘기 때문입니다. Ceph 클러스터, 대상, Veeam 백업 작업으로부터의 워크로드는 가벼워요. Ceph 클러스터는 작업 시간의 6%에서 1%만 바쁩니다.

이전 벤치마크와 비교하여 VM 백업의 처리 속도는 SSD 백업보다 훨씬 낮습니다.이는 주로 VM 데이터가 하드 드라이브에 저장되기 때문입니다.

테이블 3.

| 디스크 크기 (HDD) | 127GB |

| 소스에서 읽은 데이터 | 37.9GB |

| 데이터가 Ceph로 전송되었습니다. 중복 제거 및 압축 | 21.4GB |

| 중복 제거 | 3.3배 |

| 압축 | 1.8배 |

표 4. SATA3 HDD에 가상 머신 이미지 백업

|

백업 저장소 |

지속 시간 (초) |

원본 (%) |

프록시 (%) |

네트워크 (%) |

대상 (%) |

처리 중 속도 (MB/s) |

평균 데이터 쓰기 속도 (MB/s) |

|

리눅스 VM, RBD 볼륨, EC | 363 | 99 | 7 | 3 | 6 | 145 | 60 |

|

리눅스 VM, CephFS 볼륨, EC | 377 | 99 | 7 | 2 | 1 | 142 | 58.1 |

|

리눅스 서버, RBD 볼륨, EC | 375 | 99 | 6 | 2 | 2 | 140 | 58.4 |

참고: 평균 데이터 쓰기 속도는 전송된 데이터를 기간으로 나눈 값입니다. 이 속도는 백업 작업에서 Ceph 클러스터의 작업량을 나타냅니다.

(3)ESXi에서 HDD에 가상 머신 백업

이 테스트는 VMWare ESXi 6.5 호스트의 HDD에서 실행되는 CentOS 7 및 Windows 10 가상 머신을 Ceph RBD로 지원되는 저장소에 4+2 손실 보정 코드 보호로 백업합니다.

표 5.

| 원본 | CentOS VM | 윈도우즈 10 VM |

| 디스크 크기 (HDD) | 40GB | 32GB |

| 소스에서 읽은 데이터 | 1.8GB | 12.9GB |

| 데이터가 Ceph로 전송되었습니다. 중복 제거 및 압축 | 966MB | 7.7GB |

| 중복 제거 | 22.1X | 2.5X |

| 압축 | 1.9X | 1.7X |

표 6.

|

백업 원본 |

지속 시간 (초) |

원본 (%) |

프록시 (%) |

네트워크 (%) |

대상 (%) |

처리 중 속도 (MB/s) |

평균 데이터 쓰기 속도 (MB/s) |

| CentOS 7 | 122 | 99 | 10 | 5 | 0 | 88 | 8 |

| Windows 10 | 244 | 99 | 11 | 5 | 1 | 93 | 32 |

참고: 평균 데이터 쓰기 속도는 전송된 데이터를 기간으로 나눈 값입니다. 이 속도는 백업 작업에서 Ceph 클러스터의 작업량을 나타냅니다.

결론

테스트 결과에 따르면, Ceph RBD와 CephFS는 유사한 성능을 가지고 있습니다. 이는 RBD 및 CephFS 성능 기준에 대한 우리의 경험과 일치합니다. CephFS와 RBD의 특징을 비교하면, 각각의 장단점이 있습니다. 여러 개의 저장소 서버를 배포해야 하는 경우, 각 백업 저장소 서버에 대해 RBD 이미지를 생성해야 합니다. Ceph RBD는 하나의 호스트에만 마운트할 수 있기 때문입니다. CephFS와 비교하여 RBD를 사용하는 것은 메타데이터 서버가 필요하지 않아 더 간단합니다. 생성 시 RBD 용량 크기를 할당해야 하므로, 공간이 더 필요할 때 용량을 조정해야 합니다.

CephFS를 저장소로 사용하는 경우, Ceph 클러스터에 적어도 하나의 메타데이터 서버(MDS)를 배포해야 합니다. 높은 가용성을 위해 대기 중인 메타데이터 서버도 필요합니다. Ceph RBD와 비교하여 파일 시스템에 할당량을 지정할 필요가 없습니다. 따라서 CephFS를 무제한 저장소 풀로 다룰 수 있습니다.

이 사용 사례 시연에서는 각 백업 작업에서 하나의 가상 머신만 백업합니다. 위의 테스트 보고서에 따르면, 평균 데이터 쓰기 속도는 처리 속도와 데이터 중복 제거 및 압축 효율성과 관련이 있습니다. 더 빠른 소스 디스크는 백업 작업 기간을 줄이고 처리 속도를 높입니다. 사용자의 인프라에 따라 여러 동시 작업을 배치하여 동시에 다른 개체를 백업할 수 있습니다. Ceph 스토리지는 여러 동시 작업을 지원하는 데 매우 우수한 성능을 발휘합니다.

3x Ambedded Mars 400로 구동되는 20배 HDD OSD Ceph 클러스터는 4+2 소거 코드 풀에 대해 최대 700MB/s의 집계 쓰기 처리량을 제공할 수 있습니다. 여러 개의 현재 백업 작업을 배치하면 전체 백업 시간을 줄일 수 있는 이점을 얻을 수 있습니다. Ceph 클러스터의 최대 성능은 클러스터 내 전체 디스크 드라이브 수에 거의 선형적으로 비례합니다.

이 사용 사례에서는 백업 저장소로 S3 객체 저장소를 사용하지 않았습니다. S3 객체 저장소는 Veeam Scale-Out 백업 저장소의 용량 계층 및 NAS 백업의 대상 아카이브 저장소로 사용할 수 있습니다. Ambedded UVS 관리자, ceph 관리 웹 GUI를 사용하여 쉽게 RADOS 게이트웨이를 설정하고 객체 저장소 사용자를 만들 수 있습니다.

- 다운로드

Veeam Backup & Replication 백서에서 Ceph를 저장소로 사용하는 방법

Ceph RBD 블록 장치와 CephFS 파일 시스템을 Veeam의 백업 저장소로 설정하여 가상 머신과 파일을 백업하는 방법

다운로드- 관련 제품

Mars 400PRO Ceph 스토리지 어플라이언스

Mars 400PRO

Mars 400 Ceph Appliance는 고용량 클라우드 네이티브 데이터 저장 요구를 충족하기 위해 설계되었습니다. 저렴한 비용 당 TB를...

세부