Veeam резервное копирование и архивирование для работы с Ceph

В этом кейс-стади объясняется, как использовать хранилище данных Mars 400 ceph в качестве резервных репозиториев для резервного копирования и репликации Veeam.

Ceph поддерживает объектное хранилище, блочное хранилище и файловую систему POSIX в одном кластере. В соответствии с требованиями резервного копирования, клиенты могут выбирать различные протоколы хранения для поддержки различных стратегий резервного копирования.

В этой статье мы используем блочное хранилище Ceph (Ceph RBD) и файловую систему Ceph (Cephfs) в качестве резервных репозиториев и сравниваем продолжительность резервного копирования виртуальных машин из Hyper-V и VMWare.

Архитектура резервного копирования с использованием Veeam и Ceph

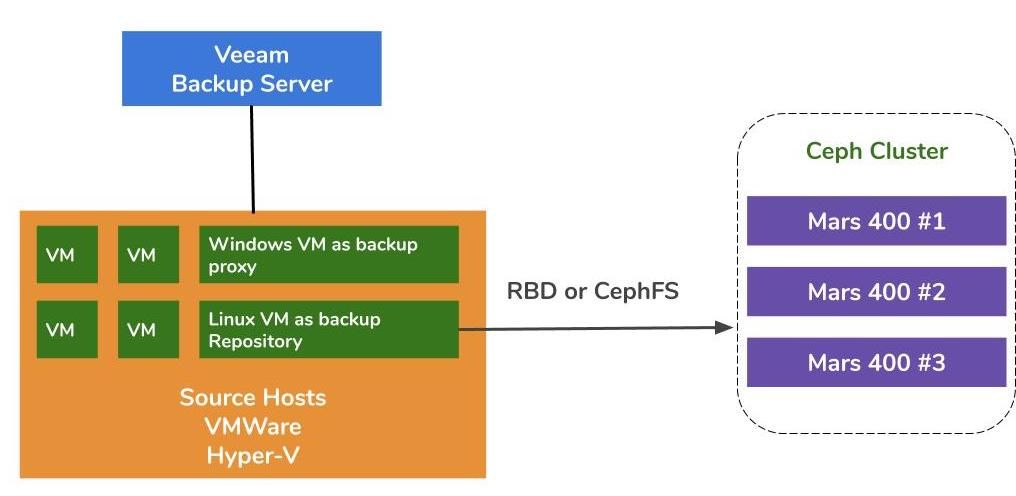

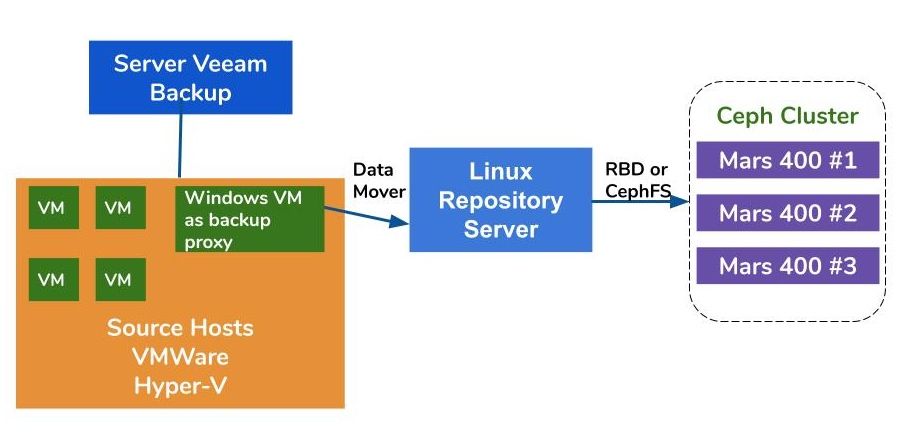

Архитектура резервного копирования виртуальных машин на VMWare и Hyper-V схожа. Veeam использует средства передачи данных для передачи данных с исходных хостов на резервные репозитории. Средства передачи данных работают на прокси-сервере и сервере репозитория. Чтобы использовать Ceph в качестве хранилища резервных копий, вы можете подключить RBD или CephFS к физическому серверу или виртуальной машине с Linux в качестве сервера репозитория.

Если прокси-серверы и серверы репозитория являются виртуальными машинами внутри кластера гипервизора, вы можете получить преимущество без сети высокоскоростной передачи данных между диском виртуальной машины, прокси-сервером и сервером репозитория. Наилучшая конфигурация большого кластера гипервизора - развертывание одной виртуальной машины прокси-сервера и одной виртуальной машины сервера репозитория на каждом хосте VMWare. В противном случае вы можете развернуть одну резервную виртуальную машину прокси на каждом хосте VMWare и один хост репозитория вне хоста, чтобы снять нагрузку с вашей производственной среды VMWare.

Существует три способа использования Ambedded Ceph-аппарата в качестве репозиториев для Veeam Backup and Replication.CephFS и блочные устройства RBD могут быть использованы в качестве резервного хранилища на месте.Хранилище объектов S3 можно использовать в качестве уровня емкости для удаленного местоположения.

Для настройки блочного устройства Ceph RBD и файловой системы CephFS в качестве резервного хранилища Veeam для резервного копирования виртуальных машин и файлов вы можете найти подробности в белой бумаге в конце этой страницы.

Тестовая среда

Кластер Ceph

- Три Mars 400 с 3-мя мониторами, 20 OSD и 1-м MDS (сервером метаданных)

- Каждый демон Ceph работает на одном двухъядерном микросервере Arm A72

- Операционная система: CentOS 7

- Ceph-программное обеспечение: Nautilus 14.2.9 Arm64

- Сеть: 4x 10 Гбит/с сеть на каждом Mars 400

Veeam Backup & Replication 10, Версия: 10.0.1.4854

Сервер резервного копирования Veeam

- ЦПУ: Intel Xeon E5-2630 2.3GHz ДУАЛЬНЫЙ

- ОЗУ: 64GB

- Сеть: 2x 10Gb sfp+ связывание

- Диск: 1TB для системы, 256GB SATA3 SSD для объема

- Windows Server 2019

Veeam Прокси Сервер

- совместное размещение с Veeam Сервером Резервного Копирования

Сервер Репозитория

- Виртуальная Машина

◇ ЦПУ: 4 ядра 2.3GHz

◇ ОЗУ: 8 ГБ

◇ Сеть: мост

◇ Диск: 50 ГБ виртуальный диск

◇ ОС: CentOS 7.8.2003

- Выделенный сервер

◇ Процессор: Intel Xeon X5650 2.67 ГГц DUAL

◇ ОЗУ: 48 ГБ

◇ Сеть: 2-портовое 10 Гб sfp+ соединение

◇ Диск: 1 ТБ для системы

◇ ОС: CentOS 7.6.1810

Хост Hyper-V

◇ Процессор: Intel Xeon E5-2630 2.3 ГГц ДВУХЯДЕРНЫЙ

◇ ОЗУ: 64 ГБ

◇ Сеть: 2-портовая связка 10Gb sfp+

◇ Диск: 1TB для системы

◇ Windows сервер 2019

Хост VMWare

◇ Процессор: Intel Xeon E5-2630 2.3 ГГц ДВУХЯДЕРНЫЙ

◇ ОЗУ: 64 ГБ

◇ Сеть: 2-портовая связка 10Gb sfp+

◇ Диск: 1TB для системы

◇ ESXi 6.5

Сеть: коммутатор 10GbE

Тестирование на различных настройках

Для тестирования производительности резервного копирования различных резервных хранилищ мы настроили тесты с различными резервными хранилищами и тремя источниками резервного копирования.

Источники резервного копирования, которые мы использовали для тестов, - это том на основе SATA SSD на сервере, виртуальная машина Windows Hyper-V и виртуальная машина CentOS 7 и виртуальная машина Windows VMWare.

(1) Резервное копирование тома на SSD-диске

Таблица 1. Резервное копирование тома с сервера с использованием SATA SSD.

| Размер диска (обработанные данные) | 237.9 ГБ |

| Данные, прочитанные с источника | 200.1 ГБ |

| Передача данных в Ceph после дедупликации и сжатия | 69.7 ГБ |

| Дедупликация | 1.3X |

| Сжатие | 2.7X |

Таблица 2.

|

Резервное копирование Репозиторий |

Продолжительность (сек) |

Источник (%) |

Прокси (%) |

Сеть (%) |

Цель (%) |

Обработка Скорость (МБ/с) |

Среднее Запись данных Скорость (МБ/с) |

|

Linux VM, RBD-реплика 3 | 646 | 83 | 33 | 84 | 21 | 554 | 110 |

|

Linux VM, CephFS-реплика 3 | 521 | 97 | 25 | 31 | 5 | 564 | 137 |

|

Linux VM, RBD, EC | 645 | 82 | 34 | 83 | 24 | 554 | 111 |

|

Linux VM, CephFS, EC | 536 | 97 | 26 | 27 | 4 | 564 | 133 |

|

Linux Server, RBD, EC | 526 | 97 | 21 | 16 | 3 | 561 | 136 |

Примечание: Средние показатели записи данных рассчитываются путем деления переданных данных на продолжительность. Эти показатели представляют нагрузку на кластер Ceph в этих резервных копиях.

(2) Создание резервной копии виртуальной машины Windows 10 на Hyper-V на HDD

В этом тесте мы создаем резервную копию экземпляра Hyper-V, который хранится на жестком диске SATA. Скорости обработки этих задач достигают верхнего предела пропускной способности HDD. Мы также можем обнаружить, что узкое место находится на источнике, потому что их нагрузка занята в течение 99% времени выполнения задания. Кластер Ceph, цель, нагрузка от резервных копий Veeam легкая. Кластер Ceph занят только на 6% до 1% рабочего времени.

По сравнению с предыдущими показателями, скорость обработки резервной копии виртуальной машины значительно ниже, чем у резервной копии на SSD.Это в основном связано с тем, что данные ВМ хранятся на жестком диске.

Таблица 3.

| Размер диска (HDD) | 127 ГБ |

| Чтение данных из источника | 37.9 ГБ |

| Данные переданы в Ceph после Дедупликации и сжатия | 21.4GB |

| Дедупликация | 3.3X |

| Сжатие | 1.8X |

Таблица 4. Резервное копирование образа виртуальной машины на жестком диске SATA3

|

Резервное копирование Репозиторий |

Продолжительность (сек) |

Источник (%) |

Прокси (%) |

Сеть (%) |

Цель (%) |

Обработка Скорость (МБ/с) |

Среднее Запись данных Скорость (МБ/с) |

|

Linux VM, Том RBD, EC | 363 | 99 | 7 | 3 | 6 | 145 | 60 |

|

Linux VM, Том CephFS, ЕС | 377 | 99 | 7 | 2 | 1 | 142 | 58.1 |

|

Linux Server, Том RBD, EC | 375 | 99 | 6 | 2 | 2 | 140 | 58.4 |

Примечание: Средние показатели записи данных рассчитываются путем деления переданных данных на продолжительность. Эти показатели представляют нагрузку на кластер Ceph в этих резервных копиях.

(3)Резервное копирование виртуальных машин на ESXi на жестком диске

Этот тест создает резервную копию виртуальных машин CentOS 7 и Windows 10, работающих на жестком диске хоста VMWare ESXi 6.5, в репозиторий, поддерживаемый Ceph RBD с защитой кодированием 4+2.

Таблица 5.

| Источник | Виртуальная машина CentOS | Виртуальная машина Windows 10 |

| Размер диска (HDD) | 40 ГБ | 32 ГБ |

| Чтение данных из источника | 1.8 ГБ | 12.9 ГБ |

| Данные переданы в Ceph после Дедупликации и сжатия | 966 МБ | 7.7 ГБ |

| Дедупликация | 22.1X | 2.5X |

| Сжатие | 1.9X | 1.7X |

Таблица 6.

|

Резервное копирование Источник |

Продолжительность (сек) |

Источник (%) |

Прокси (%) |

Сеть (%) |

Цель (%) |

Обработка Скорость (МБ/с) |

Среднее Запись данных Скорость (МБ/с) |

| CentOS 7 | 122 | 99 | 10 | 5 | 0 | 88 | 8 |

| Windows 10 | 244 | 99 | 11 | 5 | 1 | 93 | 32 |

Примечание: Средние показатели записи данных рассчитываются путем деления переданных данных на продолжительность. Эти показатели представляют нагрузку на кластер Ceph в этих резервных копиях.

Выводы

Согласно результатам тестирования, Ceph RBD и CephFS имеют схожую производительность. Это соответствует нашему опыту в отношении показателей производительности RBD и CephFS. Сравнивая характеристики CephFS и RBD, у них есть свои преимущества и недостатки. Если вам нужно развернуть несколько серверов репозиториев, вам нужно создать образ RBD для каждого сервера резервного копирования, так как вы можете монтировать только один Ceph RBD на одном хосте. По сравнению с CephFS, использование RBD проще, так как оно не требует серверов метаданных. При создании необходимо назначить размер емкости RBD, поэтому вам нужно изменить ее емкость, когда вам нужно больше места.

Если вы используете CephFS в качестве репозитория, вам необходимо развернуть как минимум один сервер метаданных (MDS) в кластере Ceph. Нам также нужен резервный сервер метаданных для обеспечения высокой доступности. По сравнению с Ceph RBD, вам не нужно устанавливать квоту для файловой системы. Таким образом, вы можете рассматривать CephFS как бесконечный пул хранения.

В этой демонстрации использования наша тестирование резервного копирования выполняется только для одной виртуальной машины в каждой задаче резервного копирования. Исходя из вышеприведенных отчетов о тестировании, мы знаем, что средняя скорость записи данных зависит от скорости обработки, а также от эффективности дедупликации и сжатия данных. Более быстрый исходный диск сокращает время выполнения задачи резервного копирования и приводит к более высокой скорости обработки. В зависимости от инфраструктуры пользователей, пользователи могут развернуть несколько одновременных задач для резервного копирования различных объектов одновременно. Хранилище Ceph отлично справляется с поддержкой нескольких одновременных задач.

20-кратный кластер HDD OSD Ceph, работающий на базе 3-х Ambedded Mars 400, может предложить до 700 МБ/с агрегированной пропускной способности записи в пул с кодом исправления ошибок 4+2. Развертывание нескольких текущих заданий резервного копирования позволяет сократить общую продолжительность резервного копирования. Максимальная производительность кластера Ceph практически пропорциональна общему количеству дисковых накопителей в кластере.

В этом случае мы не тестировали использование хранилища объектов S3 в качестве резервного репозитория. Хранилище объектов S3 может использоваться в качестве уровня емкости в резервном репозитории Veeam Scale-Out и целевом архивном репозитории для резервного копирования NAS. Вы можете легко настроить шлюз RADOS и создать пользователей хранилища объектов с помощью Ambedded UVS-менеджера, веб-интерфейса управления Ceph.

- Скачать

Используйте Ceph в качестве репозитория для документации Veeam Backup & Replication

Как настроить блочное устройство Ceph RBD и файловую систему CephFS в качестве резервного...

Скачать- Связанные продукты

Хранилище Ceph Mars 400PRO

Mars 400PRO

Mars 400 Ceph Appliance разработан для удовлетворения высоких потребностей в хранении данных...

Подробности