Используйте Mars 400 Ceph для резервного копирования с диска на диск, восстановления после катастрофы с многоплощадочной системой RGW

Какие проблемы возникают у большинства пользователей IT при планировании системы резервного копирования с диска на диск для предприятия?

Масштабируемость: Размер хранилища не останется постоянным, особенно для решения резервного копирования. Большинство пользователей рассматривают возможность использования масштабируемого хранилища по требованию.

Отказоустойчивость и самоуправление: Решение должно оставаться отказоустойчивым без вмешательства или наблюдения.

Простота и постоянная доступность: Решение для резервного копирования должно повышать гибкость и снижать накладные расходы, обеспечивая доступность данных в простом подходе.

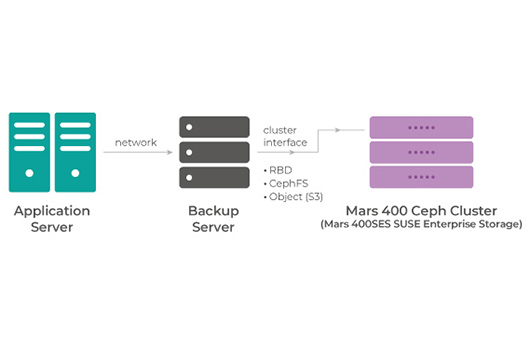

Сценарий резервного копирования хранилища Ceph:

Резервный сервер получает данные от серверов приложений, работающих в корпоративной сети. Резервный сервер организует данные, выполняет дедупликацию или сжатие, а затем сохраняет данные в кластер хранения Ceph.

Кластер Ceph может представляться резервному серверу в виде блочного устройства, файловой системы или шлюза объектов, в зависимости от протокола интерфейса, необходимого для подключения резервных серверов.

Если резервные серверы работают на операционной системе Linux и требуют общей файловой системы, CephFS будет идеальным кандидатом. Если каждый резервный сервер записывает данные на свой том, пользователь может использовать RBD или ISCSi. RBD предпочтительнее, если резервный сервер использует Linux в качестве клиента Linux, использующего RBD для прямой записи на каждое устройство хранения в кластере Ceph.

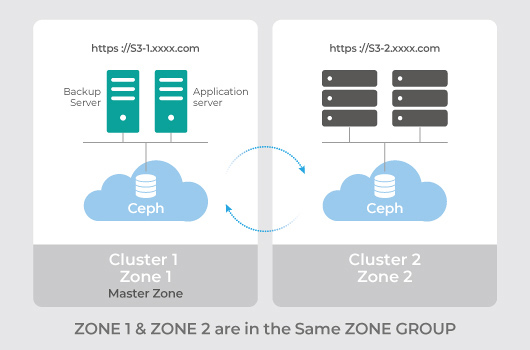

Здесь мы больше сосредоточимся на новейшем протоколе S3, который становится все более популярным в большинстве резервных приложений, так как он может интегрироваться с поддержкой многоплощадочной системы Ceph RGW для резервного копирования с функцией восстановления после катастрофы в простой настройке группы ZONE.

Ceph поддерживает установку активно-активного многосайтового кластера, чтобы данные были доступны в нескольких разных местах. С помощью этой функции клиент может развернуть хранилище облачного типа S3 на разных местоположениях, и кластеры могут резервировать друг друга простым способом.

Клиенты могут использовать менеджер UVS для настройки многосайтового шлюза Rados, а также для создания группы ZONE в UVS.

Когда основная зона выходит из строя, пользователи могут использовать менеджер UVS для повышения вторичной зоны до основной и перенаправления службы приложений на конечные точки Зоны 2, чтобы служба и бизнес-приложение могли продолжать работу без прерываний.

Этот локальный S3 может быть интегрирован с серверами резервного копирования, так что у клиента может быть одно и то же облачное хранилище резервных копий на нескольких местах (в соответствии с правилами регулирования или корпоративным управлением). Эти функции также могут предоставлять хранилище S3 напрямую службе приложений.

Пример страховых клиентов:

Клиент хочет использовать облачное хранилище, чтобы позволить своим страховым агентам запускать свое приложение, загружать и скачивать информацию о полисах. Эта услуга не может быть построена на общедоступном облаке из-за ограничений регулирования, при этом данные должны храниться как минимум в двух разных местах. В этих условиях клиенты используют S3 через хранилище Mars 400 ceph в 2 разных местах датацентра, чтобы предоставить свои облачные услуги продавцу. Данные в ведре в Кластере 1 активно синхронизируются с ведром в Кластере 2, что обеспечивает высокую доступность данных, не беспокойтесь, если в одном из кластеров произойдет неожиданная авария.

- Связанные продукты

Хранилище Ceph Mars 400PRO

Mars 400PRO

Mars 400 Ceph Appliance разработан для удовлетворения высоких потребностей в хранении данных...

Подробности- Связанная технология

Высокая доступность и надежность данных

Хранение объектов Ceph достигает доступности данных через репликацию и передовое кодирование...