Veeam back-up en archivering om te werken met Ceph

Deze casestudy legt uit hoe de Mars 400 Ceph-opslagapplicatie kan worden gebruikt als back-uprepository voor Veeam-back-up en replicatie.

Ceph ondersteunt objectopslag, blokopslag en het POSIX-bestandssysteem allemaal in één cluster. Volgens de back-upvereisten kunnen klanten verschillende opslagprotocollen selecteren om aan de behoeften van verschillende opslagback-upstrategieën te voldoen.

In dit artikel gebruiken we Ceph blokopslag (Ceph RBD) en Ceph-bestandssysteem (Cephfs) als back-uprepositories en vergelijken we de duur van hun back-uptaken bij het maken van back-ups van virtuele machines vanuit Hyper-V en VMWare.

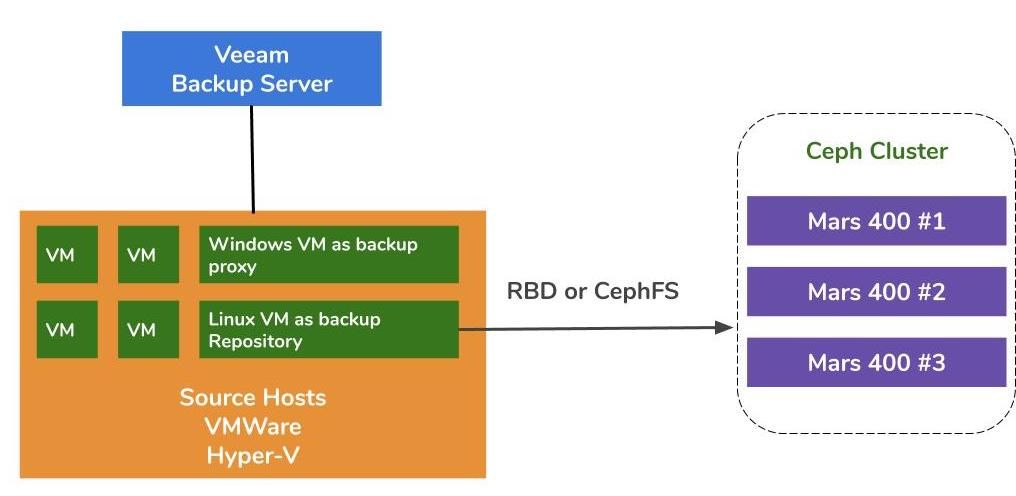

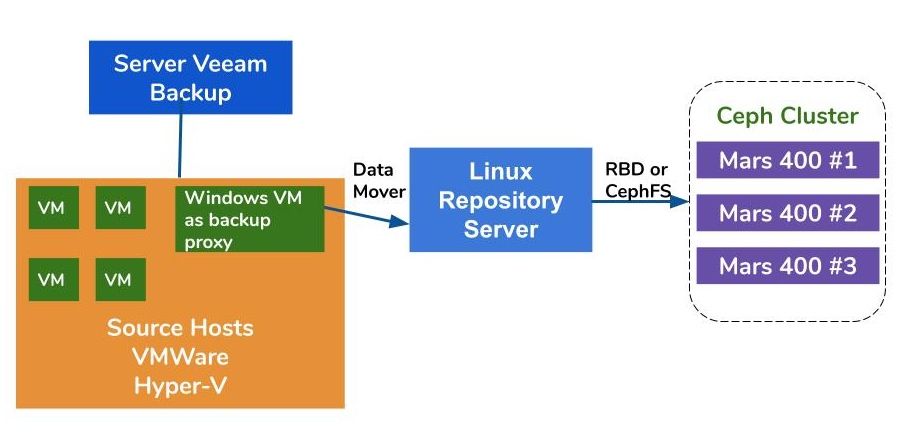

Back-upoplossingsarchitectuur door gebruik te maken van Veeam en Ceph

De architectuur van het maken van back-ups van virtuele machines op VMWare en Hyper-V is vergelijkbaar. Veeam maakt gebruik van dataverplaatsers om gegevens over te brengen van bronhosts naar back-uprepositories. De dataverplaatsers worden uitgevoerd op de proxyserver en de repositoryserver. Om Ceph te gebruiken als de backend-opslag van een back-uprepository, kunt u RBD of CephFS koppelen aan een fysieke server of virtuele machine met Linux als de repositoryserver.

Als de proxy- en repository-servers virtuele machines zijn binnen de hypervisor-cluster, kunt u profiteren van netwerkloos, snel datatransport tussen de VM-schijf, de proxyserver en de repositoryserver. De beste configuratie van een groot hypervisor-cluster is om één proxyserver-VM en één repositoryserver-VM op elke VMWare-host te implementeren. Anders kunt u één back-up proxy-VM implementeren op elke VMWare-host en één off-host repository-host om de werklast van uw productie-VMWare te verminderen.

Er zijn drie manieren om de Ambedded Ceph-appliance te gebruiken als opslagplaatsen voor Veeam Backup and Replication.CephFS en RBD blokapparaten kunnen worden gebruikt als de on-premises back-upopslagplaats.De S3-objectopslag kan worden gebruikt als capaciteitslaag voor een externe locatie.

Voor informatie over het instellen van het Ceph RBD blokapparaat en het CephFS bestandssysteem als de back-upopslag van Veeam voor het back-uppen van virtuele machines en bestanden, kunt u de details vinden in de whitepaper aan het einde van deze pagina.

Testomgeving

Ceph Cluster

- Drie Mars 400 met 3x monitoren, 20 OSD's, en 1x MDS (metadata server)

- Elke Ceph daemon draait op een dual-core Arm A72 microserver

- Besturingssysteem: CentOS 7

- Ceph software: Nautilus 14.2.9 Arm64

- Netwerk: 4x 10Gb netwerk per Mars 400

Veeam Backup & Replicatie 10, Versie: 10.0.1.4854

Veeam Backup Server

- CPU: Intel Xeon E5-2630 2.3GHz DUAL

- DRAM: 64GB

- Netwerk: 2x 10Gb sfp+ verbinding

- Schijf: 1TB voor het systeem, 256GB SATA3 SSD voor volume

- Windows Server 2019

Veeam Proxy Server

- Colloceren met Veeam Backup Server

Opslagserver

- Virtuele Machine

◇ CPU: 4 kernen 2.3GHz

◇ DRAM: 8GB

◇ Netwerk: brug

◇ Schijf: 50GB virtuele schijf

◇ Besturingssysteem: CentOS 7.8.2003

- Baremetal Server

◇ Processor: Intel Xeon X5650 2.67GHz DUAL

◇ DRAM: 48GB

◇ Netwerk: 2-poort 10Gb sfp+ verbinding

◇ Schijf: 1TB voor het systeem

◇ Besturingssysteem: CentOS 7.6.1810

Hyper-V Gastheer

◇ CPU: Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM: 64GB

◇ Netwerk: 2-poort 10Gb sfp+ bonding

◇ Schijf: 1TB voor systeem

◇ Windows Server 2019

VMWare Host

◇ CPU: Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM: 64GB

◇ Netwerk: 2-poort 10Gb sfp+ bonding

◇ Schijf: 1TB voor systeem

◇ ESXi 6.5

Netwerk: 10GbE-switch

Benchmark op verschillende configuraties

Om de back-upprestaties van verschillende back-uprepositories te benchmarken, hebben we tests opgezet met verschillende back-uprepositories en drie back-upbronnen.

De back-upbronnen die we voor de tests gebruiken, zijn een volume op basis van een SATA SSD op een server, een Windows VM van Hyper-V en een CentOS 7 VM en een Windows VM van VMWare.

(1) Back-up van een volume op een SSD-schijf

Tabel 1. Back-up van een volume van een server met een SATA SSD.

| Schijfgrootte (verwerkte gegevens) | 237,9 GB |

| Gegevens gelezen van de bron | 200,1 GB |

| Gegevens Overgedragen naar Ceph na Deduplicatie en Compressie | 69.7GB |

| Deduplicatie | 1.3X |

| Compressie | 2.7X |

Tabel 2.

|

Back-up Opslagplaats |

Duur (sec) |

Bron (%) |

Proxy (%) |

Netwerk (%) |

Doelwit (%) |

Verwerking Snelheid (MB/s) |

Gemiddelde Data Schrijven Snelheid (MB/s) |

|

Linux VM, RBD-replica 3 | 646 | 83 | 33 | 84 | 21 | 554 | 110 |

|

Linux VM, CephFS-replica 3 | 521 | 97 | 25 | 31 | 5 | 564 | 137 |

|

Linux VM, RBD, EC | 645 | 82 | 34 | 83 | 24 | 554 | 111 |

|

Linux VM, CephFS, EC | 536 | 97 | 26 | 27 | 4 | 564 | 133 |

|

Linux Server, RBD, EC | 526 | 97 | 21 | 16 | 3 | 561 | 136 |

Opmerking: De gemiddelde gegevensschrijfsnelheden worden berekend door de overgedragen gegevens te delen door de duur. Deze snelheden vertegenwoordigen de workloads van de Ceph-cluster in deze back-uptaken.

(2)Maak een back-up van een Windows 10-VM op Hyper-V op HDD

In deze benchmark maken we een back-up van een Hyper-V-instantie die is opgeslagen op een SATA-harde schijf. De verwerkingssnelheden van deze taken bereiken de bovengrens van de HDD-bandbreedte. We kunnen ook vinden dat de bottleneck zich bevindt bij de bron omdat hun belastingen gedurende 99% van de taakduur druk bezig zijn. Ceph-cluster, het doel, de werklast van de Veeam-back-uptaken is licht. Ceph-cluster is slechts druk bezig gedurende 6% tot 1% van de werktijd.

Vergeleken met de vorige benchmark is de verwerkingssnelheid van de VM-back-up veel lager dan die van de SSD-back-up.Dit komt voornamelijk doordat de VM-gegevens worden opgeslagen op een harde schijf.

Tabel 3.

| Schijfgrootte (HDD) | 127GB |

| Gegevens gelezen van bron | 37.9GB |

| Gegevens overgedragen naar Ceph na Deduplicatie en Compressie | 21,4GB |

| Deduplicatie | 3,3X |

| Compressie | 1,8X |

Tabel 4. Maak een back-up van een virtuele machine-image op een SATA3 HDD

|

Back-up Opslagplaats |

Duur (sec) |

Bron (%) |

Proxy (%) |

Netwerk (%) |

Doelwit (%) |

Verwerking Snelheid (MB/s) |

Gemiddelde Data Schrijven Snelheid (MB/s) |

|

Linux VM, RBD-volume, EC | 363 | 99 | 7 | 3 | 6 | 145 | 60 |

|

Linux VM, CephFS-volume, EC | 377 | 99 | 7 | 2 | 1 | 142 | 58.1 |

|

Linux Server, RBD-volume, EC | 375 | 99 | 6 | 2 | 2 | 140 | 58.4 |

Opmerking: De gemiddelde gegevensschrijfsnelheden worden berekend door de overgedragen gegevens te delen door de duur. Deze snelheden vertegenwoordigen de workloads van de Ceph-cluster in deze back-uptaken.

(3)Back-up virtuele machines op ESXi op HDD

Deze test maakt een back-up van een CentOS 7 en een Windows 10 virtuele machines die draaien op een HDD van een VMWare ESXi 6.5 host naar een repository ondersteund door een Ceph RBD met 4+2 erasure code bescherming.

Tabel 5.

| Bron | CentOS VM | Windows 10 VM |

| Schijfgrootte (HDD) | 40GB | 32GB |

| Gegevens gelezen van bron | 1,8GB | 12,9GB |

| Gegevens overgedragen naar Ceph na Deduplicatie en Compressie | 966MB | 7,7GB |

| Deduplicatie | 22,1X | 2,5X |

| Compressie | 1.9X | 1.7X |

Tabel 6.

|

Back-up Bron |

Duur (sec) |

Bron (%) |

Proxy (%) |

Netwerk (%) |

Doelwit (%) |

Verwerking Snelheid (MB/s) |

Gemiddelde Data Schrijven Snelheid (MB/s) |

| CentOS 7 | 122 | 99 | 10 | 5 | 0 | 88 | 8 |

| Windows 10 | 244 | 99 | 11 | 5 | 1 | 93 | 32 |

Opmerking: De gemiddelde gegevensschrijfsnelheden worden berekend door de overgedragen gegevens te delen door de duur. Deze snelheden vertegenwoordigen de workloads van de Ceph-cluster in deze back-uptaken.

Conclusies

Volgens de testresultaten hebben Ceph RBD en CephFS een vergelijkbare prestatie. Dit komt overeen met onze ervaring met betrekking tot de benchmark van RBD en CephFS-prestaties. Bij het vergelijken van de kenmerken van CephFS en RBD, hebben ze beide hun voor- en nadelen. Als je meerdere repository servers wilt implementeren, moet je een RBD-image maken voor elke back-up repository server, omdat je Ceph RBD slechts op één host kunt mounten. In vergelijking met CephFS is het gebruik van RBD eenvoudiger omdat het geen metadata-servers nodig heeft. Bij het aanmaken moeten we de RBD-capaciteitsgrootte toewijzen, dus je moet de capaciteit vergroten wanneer je meer ruimte nodig hebt.

Als u CephFS als het repository gebruikt, moet u ten minste één metadata server (MDS) implementeren in de Ceph cluster. We hebben ook een standby metadata server nodig voor hoge beschikbaarheid. In vergelijking met Ceph RBD, hoeft u het bestandssysteem geen quotum te geven. U kunt dus CephFS behandelen als een onbeperkte opslagpool.

In deze demonstratie van het gebruiksscenario maken onze tests alleen een back-up van één virtuele machine in elke back-uptaak. Volgens de bovenstaande testrapporten weten we dat de gemiddelde gegevensschrijfsnelheid verband houdt met de verwerkingssnelheid en de efficiëntie van gegevensdeduplicatie en compressie. Een snellere bron schijf verkort de duur van de back-uptaak en resulteert in een snellere verwerkingssnelheid. Afhankelijk van de infrastructuur van gebruikers kunnen ze meerdere gelijktijdige taken implementeren om verschillende objecten tegelijkertijd te back-uppen. Ceph-opslag presteert zeer goed bij het ondersteunen van meerdere gelijktijdige taken.

Een 20x HDD OSD Ceph-cluster, aangedreven door 3x Ambedded Mars 400, kan een geaggregeerde schrijfdoorvoer bieden tot 700MB/s aan de 4+2 erasure code pool. Het implementeren van meerdere huidige back-uptaken heeft als voordeel dat de algehele back-upduur wordt verminderd. De maximale prestatie van een Ceph-cluster is bijna lineair evenredig met het totale aantal schijfstations in het cluster.

In dit gebruiksscenario hebben we geen gebruik gemaakt van S3-objectopslag als back-uprepository. S3-objectopslag kan worden gebruikt als capaciteitstier in de Veeam Scale-Out back-uprepository en als doelarchiefrepository voor NAS-back-up. U kunt eenvoudig een RADOS-gateway instellen en objectopslaggebruikers maken met behulp van de Ambedded UVS-manager, de ceph-beheerwebinterface.

- Downloaden

Gebruik Ceph als de repository voor Veeam Backup & Replication whitepaper

Hoe de Ceph RBD-blokapparaat en het CephFS-bestandssysteem in te stellen als de back-uprepository van Veeam voor het maken van back-ups van virtuele machines...

Downloaden- Gerelateerde producten

Mars 400PRO Ceph opslagapparaat

Mars 400PRO

Mars 400 Ceph Appliance is ontworpen om te voldoen aan de hoge capaciteitseisen voor cloud-native gegevensopslag. Het maakt gebruik van HDD om te profiteren...

Details