Hoge gegevensbeschikbaarheid en duurzaamheid.

Ceph objectopslag bereikt gegevensbeschikbaarheid door replicatie en geavanceerde foutcorrectie, waarbij gegevens worden gecombineerd met pariteitsinformatie en vervolgens worden verdeeld over de opslagpool.

Wanneer een opslagapparaat uitvalt, is slechts een subset van de fragmenten nodig om de gegevens te herstellen, er is geen herbouwtijd of verminderde prestaties, en defecte opslagapparaten kunnen worden vervangen wanneer het uitkomt.

Ceph combineert wijdverspreide gegevens en technologie voor gegevenscontrole die continu de op de media geschreven gegevens valideert, zodat u een gegevensduurzaamheid van 15 negens kunt bereiken.

Gegevensreplicatie, foutcorrectie en controle.

Object Replikatie

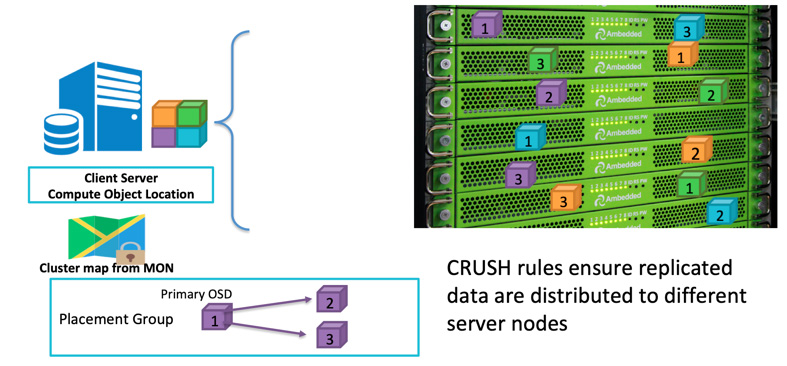

Wanneer een client gegevens gaat schrijven, gebruikt het object-ID en poolnaam om te berekenen naar welke OSD het moet schrijven. Nadat de client gegevens naar de OSD schrijft, kopieert de OSD de gegevens naar één of meer OSD's. U kunt zoveel replicaties configureren als u wilt om ervoor te zorgen dat de gegevens kunnen overleven in het geval dat meerdere OSD's tegelijkertijd uitvallen. De replicatie is vergelijkbaar met de RAID-1 van een schijfarray, maar staat meer kopieën van gegevens toe. Omdat op grote schaal een eenvoudige RAID-1-replicatie mogelijk niet voldoende is om het risico op hardwarefouten af te dekken. Het enige nadeel van het opslaan van meer replica's is de opslagkosten.

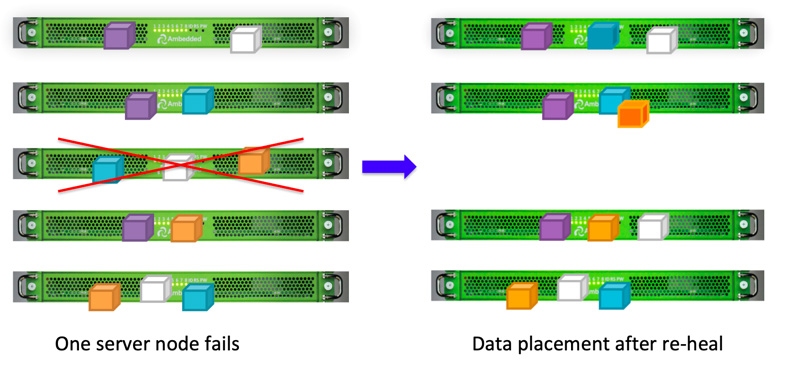

Ceph-clients schrijven gegevens willekeurig naar OSDs op basis van het CRUSH-algoritme.Als de OSD-schijf of -node uitvalt, kan Ceph de gegevens opnieuw genezen uit andere replicaties die zijn opgeslagen in gezonde OSDs.

U kunt het faaldomein definiëren om Ceph gerepliceerde gegevens op verschillende servers, rekken, ruimtes of datacenters op te slaan om gegevensverlies te voorkomen als gevolg van één of meer storingen in het hele faaldomein.Bijvoorbeeld, als je 15 opslagservers hebt geïnstalleerd in 5 racks (3 servers in elk rack), kun je replica drie en rack gebruiken als het storingsdomein.Gegevens die naar de ceph-cluster worden geschreven, worden altijd opgeslagen in drie kopieën in drie van de vijf rekken.Gegevens kunnen overleven als er maximaal 2 rekken uitvallen zonder dat de klantenservice wordt aangetast.De CRUSH-regel is de sleutel om ervoor te zorgen dat Ceph-opslag geen enkel punt van falen heeft.

Wissercodering

Replicatie biedt de beste algehele prestaties, maar is niet erg ruimte-efficiënt.Vooral als u een hogere mate van redundantie nodig hebt.

Om een hoge beschikbaarheid van gegevens te hebben, is dat de reden waarom we in het verleden RAID-5 of RAID-6 hebben gebruikt als alternatief voor RAID-1.Parity RAID zorgt voor redundantie met veel minder opslagoverhead, maar ten koste van de opslagprestaties (voornamelijk schrijfprestaties).Ceph maakt gebruik van foutcorrectiecodering om een vergelijkbaar resultaat te bereiken.Wanneer de omvang van uw opslagsysteem groot wordt, kunt u zich onzeker voelen over het toestaan van slechts één of twee schijven of storingsdomeinen die tegelijkertijd uitvallen.Het erasure code-algoritme stelt u in staat een hoger niveau van redundantie te configureren, maar met minder ruimte-overhead.

Erasure coding verdeelt de oorspronkelijke gegevens in K gegevensblokken en berekent extra M codeblokken.Ceph kan de gegevens herstellen als er maximaal M foutdomeinen tegelijkertijd falen.Het totale aantal K+M chunks wordt opgeslagen in de OSD's, die zich bevinden in verschillende storingsdomeinen.

Schrobben

Als onderdeel van het behouden van gegevensconsistentie en netheid, kunnen Ceph OSD-daemons objecten binnen plaatsingsgroepen controleren. Dat wil zeggen, Ceph OSD Daemons kunnen objectmetadata vergelijken in één plaatsingsgroep met de replica's in plaatsingsgroepen die zijn opgeslagen op andere OSD's. Scrubben (meestal dagelijks uitgevoerd) vangt bugs of bestandssysteemfouten. Ceph OSD-daemons voeren ook diepere scrubbing uit door gegevens in objecten bit-voor-bit te vergelijken. Diepgaand reinigen (meestal wekelijks uitgevoerd) vindt slechte sectoren op een schijf die niet duidelijk waren bij een lichte reiniging.

Gegevensherstel

Vanwege het gegevensplaatsingsontwerp van Ceph wordt gegevens hersteld door alle gezonde OSD's. Er is geen reserve schijf nodig voor gegevensherstel. Dit kan de tijd om te herstellen aanzienlijk verkorten in vergelijking met een schijfarray, waarbij de verloren gegevens naar de reserve schijf moeten worden herbouwd.

- Configureer CRUSH-map en regels