VeeamバックアップとアーカイブをCephと連携させる

このケーススタディでは、Mars 400 CephストレージアプライアンスをVeeamバックアップとレプリケーションのバックアップリポジトリとして使用する方法について説明しています。

Cephは、1つのクラスタでオブジェクトストレージ、ブロックストレージ、およびPOSIXファイルシステムをすべてサポートしています。バックアップの要件に応じて、顧客はさまざまなストレージバックアップ戦略のニーズをサポートするために異なるストレージプロトコルを選択できます。

この記事では、Cephブロックストレージ(Ceph RBD)とCephファイルシステム(Cephfs)をバックアップリポジトリとして使用し、Hyper-VおよびVMWareから仮想マシンのバックアップジョブの所要時間を比較します。

VeeamとCephを使用したバックアップソリューションアーキテクチャ

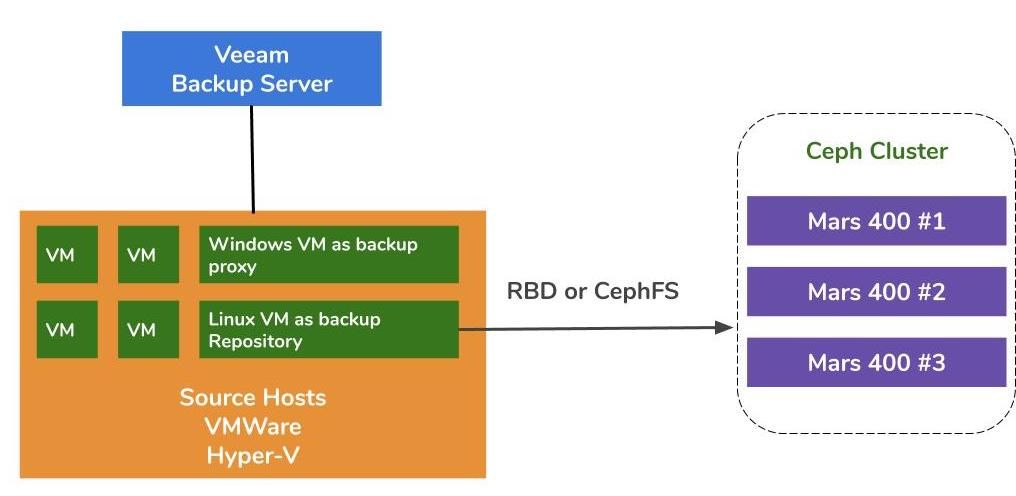

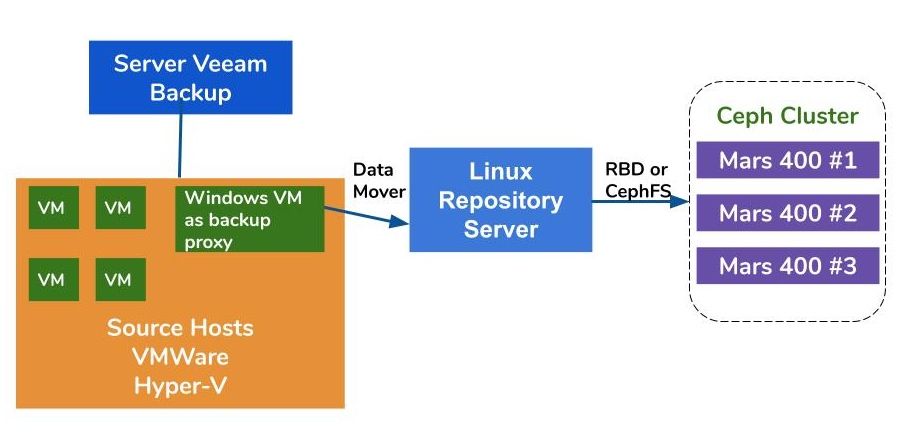

VMWareとHyper-V上の仮想マシンのバックアップのアーキテクチャは似ています。Veeamはデータムーバーを使用して、ソースホストからバックアップリポジトリへデータを転送します。データムーバーはプロキシサーバーとリポジトリサーバー上で実行されます。バックアップリポジトリのバックエンドストレージとしてCephを使用するには、Linux物理サーバーまたは仮想マシン上にRBDまたはCephFSをマウントしてリポジトリサーバーとして使用することができます。

プロキシサーバーとリポジトリサーバーがハイパーバイザクラスタ内の仮想マシンである場合、VMディスク、プロキシサーバー、およびリポジトリサーバー間でネットワークフリーの高速データ転送の利点を得ることができます。 大規模ハイパーバイザクラスタの最適な構成は、各VMWareホストに1つのプロキシサーバーVMと1つのリポジトリサーバーVMを展開することです。 それ以外の場合は、各VMWareホストに1つのバックアッププロキシVMを展開し、1つのオフホストリポジトリホストを展開して、プロダクションVMWareからのワークロードを削減することができます。

Veeam Backup and ReplicationのリポジトリとしてAmbedded Cephアプライアンスを使う方法は3つあります。CephFSとRBDブロックデバイスはオンプレミスのバックアップリポジトリとして使用できます。S3オブジェクトストレージは、リモートロケーションの容量層として使用できます。

VeeamのバックアップリポジトリとしてCeph RBDブロックデバイスとCephFSファイルシステムを設定する方法については、このページの最後にあるホワイトペーパーで詳細を確認できます。

テスト環境

- 3つのMars 400、3つのモニター、20のOSD、1つのMDS(メタデータサーバー)

- 各CephデーモンはデュアルコアのArm A72マイクロサーバーで実行されます

- オペレーティングシステム:CentOS 7

- Cephソフトウェア:Nautilus 14.2.9 Arm64

- ネットワーク:Mars 400ごとに4つの10Gbネットワーク

Veeam Backup & Replication 10、バージョン:10.0.1.4854

Veeamバックアップサーバー

- CPU: インテル ジーオン E5-2630 2.3GHz デュアル

- DRAM: 64GB

- ネットワーク: 2x 10Gb sfp+ ボンディング

- ディスク: システム用に1TB、ボリューム用に256GB SATA3 SSD

- Windows Server 2019

Veeam プロキシサーバー

- Veeam バックアップサーバーと共設

リポジトリサーバー

- 仮想マシン

◇ CPU: 4コア 2.3GHz

◇ DRAM:8GB

◇ ネットワーク:ブリッジ

◇ ディスク:50GBの仮想ディスク

◇ OS:CentOS 7.8.2003

- ベアメタルサーバー

◇ CPU:Intel Xeon X5650 2.67GHz DUAL

◇ DRAM:48GB

◇ ネットワーク:2ポート 10Gb sfp+ ボンディング

◇ ディスク:システム用1TB

◇ OS:CentOS 7.6.1810

ハイパーバイザーホスト

◇ CPU: インテル Xeon E5-2630 2.3GHz デュアル

◇ DRAM: 64GB

◇ ネットワーク:2ポート 10Gb sfp+ ボンディング

◇ ディスク:システム用の1TB

◇ Windows Server 2019

VMWareホスト

◇ CPU: インテル Xeon E5-2630 2.3GHz デュアル

◇ DRAM: 64GB

◇ ネットワーク:2ポート 10Gb sfp+ ボンディング

◇ ディスク:システム用の1TB

◇ ESXi 6.5

ネットワーク:10GbEスイッチ

さまざまなセットアップでのベンチマーク

さまざまなバックアップリポジトリのバックアップパフォーマンスをベンチマークするために、異なるバックアップリポジトリと3つのバックアップソースでテストをセットアップしました。

テストに使用するバックアップソースは、サーバー上のSATA SSDベースのボリューム、Hyper-VのWindows VM、およびCentOS 7 VMとVMWareのWindows VMです。

(1)SSDドライブ上のボリュームのバックアップ

表1. SATA SSDを使用したサーバーからのボリュームのバックアップ

| ディスクサイズ(処理データ) | 237.9GB |

| ソースからのデータ読み取り | 200.1GB |

| 重複排除と圧縮後にCephにデータ転送されました | 69.7GB |

| 重複排除 | 1.3倍 |

| 圧縮 | 2.7倍 |

表2.

|

バックアップ リポジトリ |

所要時間 (秒) |

ソース (%) |

プロキシ (%) |

ネットワーク (%) |

ターゲット (%) |

処理 速度(MB/s) |

平均 データ書き込み 速度(MB/s) |

|

Linux VM, RBD-レプリカ 3 | 646 | 83 | 33 | 84 | 21 | 554 | 110 |

|

Linux VM, CephFS-レプリカ 3 | 521 | 97 | 25 | 31 | 5 | 564 | 137 |

|

Linux VM, RBD、EC | 645 | 82 | 34 | 83 | 24 | 554 | 111 |

|

Linux VM, CephFS、EC | 536 | 97 | 26 | 27 | 4 | 564 | 133 |

|

Linuxサーバー、 RBD、EC | 526 | 97 | 21 | 16 | 3 | 561 | 136 |

注意:平均データ書き込みレートは、転送されたデータを時間で割ったものです。これらのレートは、これらのバックアップジョブにおけるCephクラスタのワークロードを表しています。

(2)HDD上のHyper-V上のWindows 10 VMのバックアップ

このベンチマークでは、SATAハードドライブに保存されているHyper-Vインスタンスをバックアップします。 これらのジョブの処理速度はHDDの帯域幅の上限に達しています。 私たちはまた、ボトルネックがソースにあることも見つけることができます。なぜなら、ジョブのほとんどの時間で彼らの負荷が忙しいからです。 Cephクラスターは、Veeamバックアップジョブからのターゲットのワークロードが軽いです。 Cephクラスターは作業時間の6%から1%しか忙しくありません。

前回のベンチマークと比較して、VMバックアップの処理速度はSSDバックアップよりもはるかに低いです。これは主に、VMデータがハードドライブに保存されているためです。

テーブル3。

| ディスクサイズ(HDD) | 127GB |

| ソースからのデータ読み取り | 37.9GB |

| データがCephに転送されました デデュープリケーションと圧縮後 | 21.4GB |

| 重複排除 | 3.3X |

| 圧縮 | 1.8X |

テーブル4. SATA3 HDD上の仮想マシンイメージのバックアップ

|

バックアップ リポジトリ |

所要時間 (秒) |

ソース (%) |

プロキシ (%) |

ネットワーク (%) |

ターゲット (%) |

処理 速度(MB/s) |

平均 データ書き込み 速度(MB/s) |

|

Linux VM, RBDボリューム、EC | 363 | 99 | 7 | 3 | 6 | 145 | 60 |

|

Linux VM, CephFSボリューム, EC | 377 | 99 | 7 | 2 | 1 | 142 | 58.1 |

|

Linuxサーバー、 RBDボリューム、EC | 375 | 99 | 6 | 2 | 2 | 140 | 58.4 |

注意:平均データ書き込みレートは、転送されたデータを時間で割ったものです。これらのレートは、これらのバックアップジョブにおけるCephクラスタのワークロードを表しています。

(3)HDD上のESXiで仮想マシンのバックアップ

このテストは、VMWare ESXi 6.5ホストのHDD上で実行されているCentOS 7およびWindows 10仮想マシンを、4+2のエラーコード保護を備えたCeph RBDでバックアップリポジトリにバックアップします。

テーブル5.

| ソース | CentOS VM | Windows 10 VM |

| ディスクサイズ(HDD) | 40GB | 32GB |

| ソースからのデータ読み取り | 1.8GB | 12.9GB |

| データがCephに転送されました デデュープリケーションと圧縮後 | 966MB | 7.7GB |

| 重複排除 | 22.1倍 | 2.5倍 |

| 圧縮 | 1.9X | 1.7X |

表6.

|

バックアップ ソース |

所要時間 (秒) |

ソース (%) |

プロキシ (%) |

ネットワーク (%) |

ターゲット (%) |

処理 速度(MB/s) |

平均 データ書き込み 速度(MB/s) |

| CentOS 7 | 122 | 99 | 10 | 5 | 0 | 88 | 8 |

| Windows 10 | 244 | 99 | 11 | 5 | 1 | 93 | 32 |

注意:平均データ書き込みレートは、転送されたデータを時間で割ったものです。これらのレートは、これらのバックアップジョブにおけるCephクラスタのワークロードを表しています。

結論

テスト結果によると、Ceph RBDとCephFSは類似したパフォーマンスを持っています。 これは、RBDとCephFSのパフォーマンスのベンチマークに関する私たちの経験に合致しています。 CephFSとRBDの特徴を比較すると、それぞれに利点と欠点があります。 複数のリポジトリサーバーを展開する必要がある場合は、バックアップリポジトリサーバーごとにRBDイメージを作成する必要があります。Ceph RBDは1つのホストにしかマウントできません。 CephFSと比較して、RBDを使用するとメタデータサーバーが不要なため、よりシンプルです。 作成時にRBDの容量サイズを割り当てる必要があるため、スペースが不足した場合は容量をリサイズする必要があります。

CephFSをリポジトリとして使用する場合、Cephクラスタに少なくとも1つのメタデータサーバ(MDS)を展開する必要があります。高可用性のために、スタンバイメタデータサーバも必要です。Ceph RBDと比較して、ファイルシステムにクォータを設定する必要はありません。そのため、CephFSを無制限のストレージプールとして扱うことができます。

このユースケースのデモンストレーションでは、バックアップジョブごとに1つのVMのみをバックアップします。上記のテストレポートによれば、平均データ書き込み速度は処理速度とデータの重複排除および圧縮効率に関連しています。より速いソースディスクは、バックアップジョブの所要時間を短縮し、より速い処理速度をもたらします。ユーザーのインフラストラクチャに応じて、複数の同時ジョブを展開して異なるオブジェクトを同時にバックアップすることができます。Cephストレージは、複数の同時ジョブをサポートするのに非常に優れています。

3つのAmbedded Mars 400によって駆動される20x HDD OSD Cephクラスターは、4+2の消去符号プールに対して最大700MB/sの集約書き込みスループットを提供することができます。複数の現在のバックアップジョブを展開することで、全体のバックアップ時間を短縮する利点が得られます。Cephクラスターの最大パフォーマンスは、クラスター内のディスクドライブの総数にほぼ比例します。

このユースケースでは、バックアップリポジトリとしてS3オブジェクトストレージを使用してテストは行いませんでした。S3オブジェクトストレージは、Veeam Scale-Outバックアップリポジトリの容量ティアとして、およびNASバックアップのターゲットアーカイブリポジトリとして使用することができます。Ambedded UVSマネージャー、ceph管理Web GUIを使用して、簡単にRADOSゲートウェイをセットアップし、オブジェクトストレージユーザーを作成することができます。

- ダウンロード

Veeam Backup & Replication のための Ceph をリポジトリとして使用するホワイトペーパー

Ceph RBD ブロックデバイスと CephFS ファイルシステムを Veeam のバックアップリポジトリとして設定し、仮想マシンやファイルをバックアップする方法

ダウンロード- 関連製品

Mars 400PRO Cephストレージアプライアンス

Mars 400PRO

Mars 400 Cephアプライアンスは、高容量のクラウドネイティブデータストレージニーズに対応するよう設計されています。...

詳細