Veeam backup i archiwizacja do pracy z Ceph

Niniejsze studium przypadku wyjaśnia, jak używać urządzenia pamięci masowej Ceph Mars 400 jako repozytoriów kopii zapasowych dla Veeam backup and replication.

Ceph obsługuje przechowywanie obiektów, bloków oraz system plików POSIX, wszystko w jednym klastrze. Zgodnie z wymaganiami dotyczącymi kopii zapasowych, klienci mogą wybrać różne protokoły przechowywania, aby sprostać potrzebom różnych strategii tworzenia kopii zapasowych.

W tym artykule wykorzystujemy blokowe przechowywanie danych Ceph (Ceph RBD) oraz system plików Ceph (Cephfs) jako repozytoriów kopii zapasowych i porównujemy czas trwania zadań tworzenia kopii zapasowych maszyn wirtualnych z Hyper-V i VMWare.

Architektura rozwiązania kopii zapasowych przy użyciu Veeam i Ceph

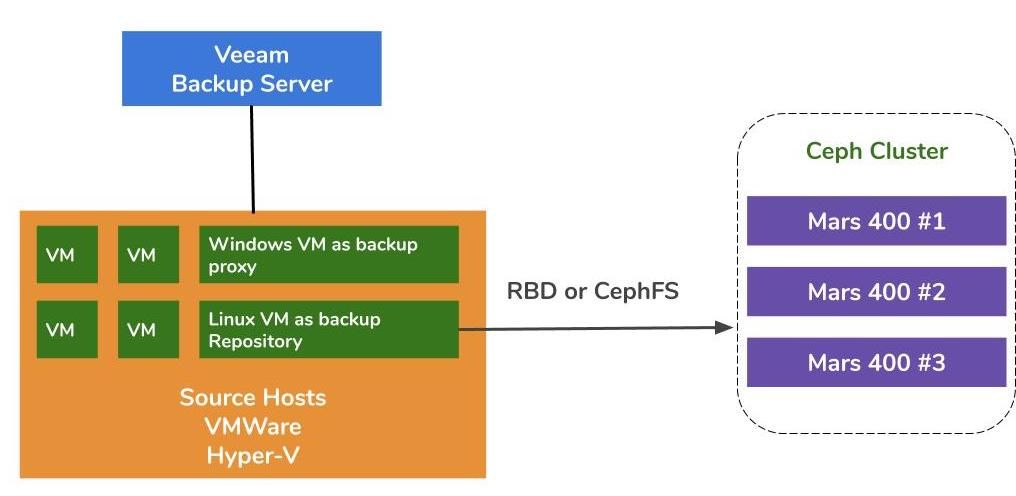

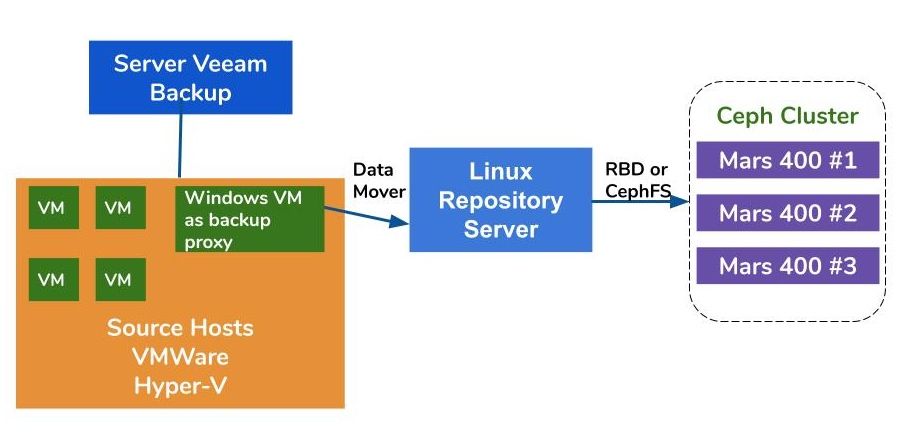

Architektura tworzenia kopii zapasowych maszyn wirtualnych na VMWare i Hyper-V jest podobna. Veeam używa przesyłaczy danych do transferu danych z hostów źródłowych do repozytoriów kopii zapasowych. Przesyłacze danych działają na serwerze proxy i serwerze repozytorium. Aby użyć Ceph jako magazynu danych dla repozytorium kopii zapasowych, można zamontować RBD lub CephFS na fizycznym serwerze Linux lub maszynie wirtualnej jako serwer repozytorium.

Jeśli serwery proxy i repozytorium są wirtualnymi maszynami w klastrze hipernadzorcy, możesz skorzystać z bezprzewodowego transportu danych o wysokiej prędkości między dyskiem maszyny wirtualnej, serwerem proxy i serwerem repozytorium. Najlepsza konfiguracja dużego klastra hypervisora polega na wdrożeniu jednego serwera proxy VM i jednego serwera repozytorium VM na każdym hoście VMWare. W przeciwnym razie możesz wdrożyć jedną kopię zapasową maszyny wirtualnej proxy na każdym hoście VMWare oraz jednego hosta repozytorium poza hostem, aby usunąć obciążenie z twojego środowiska produkcyjnego VMWare.

Istnieją trzy sposoby na wykorzystanie Ambedded urządzenia Ceph jako repozytorium dla Veeam Backup and Replication.CephFS oraz urządzenia blokowe RBD mogą być używane jako lokalne repozytorium kopii zapasowych.Magazyn obiektów S3 może być używany jako warstwa pojemności dla zdalnej lokalizacji.

Aby skonfigurować urządzenie blokowe Ceph RBD oraz system plików CephFS jako repozytorium kopii zapasowych Veeam do tworzenia kopii zapasowych maszyn wirtualnych i plików, szczegóły można znaleźć w dokumencie technicznym na końcu tej strony.

Środowisko testowe

- Trzy Mars 400 z 3x monitorami, 20 OSD i 1x MDS (serwer metadanych)

- Każdy demon Ceph działa na jednym dwurdzeniowym mikroserwerze Arm A72

- System operacyjny: CentOS 7

- Oprogramowanie Ceph: Nautilus 14.2.9 Arm64

- Sieć: 4x 10Gb sieć na Mars 400

Veeam Backup & Replication 10, Wersja: 10.0.1.4854

Serwer kopii zapasowych Veeam

- CPU: Intel Xeon E5-2630 2.3GHz DUAL

- DRAM: 64GB

- Sieć: 2x 10Gb sfp+ bonding

- Dysk: 1TB dla systemu, 256GB SATA3 SSD na wolumin

- Windows Serwer 2019

Serwer Proxy Veeam

- Kolokacja z Serwerem Backupu Veeam

Serwer Repozytorium

- Wirtualna Maszyna

◇ CPU: 4 rdzenie 2.3GHz

◇ DRAM: 8GB

◇ Sieć: most

◇ Dysk: 50GB wirtualny dysk

◇ System operacyjny: CentOS 7.8.2003

- Serwer baremetalowy

◇ Procesor: Intel Xeon X5650 2.67GHz DUAL

◇ DRAM: 48GB

◇ Sieć: 2-portowy 10Gb sfp+ bonding

◇ Dysk: 1TB na system

◇ System operacyjny: CentOS 7.6.1810

Gospodarz Hyper-V

◇ CPU: Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM: 64GB

◇ Sieć: Bonding 2-portowy 10Gb sfp+

◇ Dysk: 1TB dla systemu

◇ Serwer Windows 2019

Gospodarz VMWare

◇ CPU: Intel Xeon E5-2630 2.3GHz DUAL

◇ DRAM: 64GB

◇ Sieć: Bonding 2-portowy 10Gb sfp+

◇ Dysk: 1TB dla systemu

◇ ESXi 6.5

Sieć: przełącznik 10GbE

Testy wydajności na różnych konfiguracjach

Aby zbadać wydajność kopii zapasowych różnych repozytoriów, przeprowadziliśmy testy z różnymi repozytoriami kopii zapasowych i trzema źródłami kopii zapasowych.

Źródłami kopii zapasowych, które używamy do testów, są wolumin oparty na dysku SSD SATA na serwerze, maszyna wirtualna Hyper-V z systemem Windows oraz maszyna wirtualna CentOS 7 i maszyna wirtualna VMWare z systemem Windows.

(1)Kopia zapasowa woluminu na dysku SSD

Tabela 1. Kopia zapasowa woluminu z serwera z dyskiem SATA SSD.

| Rozmiar dysku (przetworzone dane) | 237,9GB |

| Dane odczytane ze źródła | 200,1GB |

| Przesył danych do Ceph po deduplikacji i kompresji | 69,7GB |

| Deduplikacja | 1,3X |

| Kompresja | 2,7X |

Tabela 2.

|

Kopia zapasowa Repozytorium |

Czas trwania (sek) |

Źródło (%) |

Serwer pośredniczący (%) |

Sieć (%) |

Docelowy (%) |

Przetwarzanie Szybkość (MB/s) |

Średnia Zapis danych Szybkość (MB/s) |

|

Linux VM, RBD-replika 3 | 646 | 83 | 33 | 84 | 21 | 554 | 110 |

|

Linux VM, CephFS-replika 3 | 521 | 97 | 25 | 31 | 5 | 564 | 137 |

|

Linux VM, RBD, EC | 645 | 82 | 34 | 83 | 24 | 554 | 111 |

|

Linux VM, CephFS, EC | 536 | 97 | 26 | 27 | 4 | 564 | 133 |

|

Serwer Linux, RBD, EC | 526 | 97 | 21 | 16 | 3 | 561 | 136 |

Uwaga: Średnie wskaźniki zapisu danych są obliczane jako iloraz Przesłanych danych przez Czas trwania. Te wskaźniki reprezentują obciążenia klastra Ceph w tych zadaniach tworzenia kopii zapasowych.

(2)Tworzenie kopii zapasowej maszyny wirtualnej Windows 10 na Hyper-V na dysku HDD

W tym teście porównawczym tworzymy kopię zapasową instancji Hyper-V przechowywanej na dysku SATA. Prędkości przetwarzania tych zadań osiągają górny limit przepustowości dysku HDD. Możemy również stwierdzić, że wąskim gardłem jest źródło, ponieważ ich obciążenie jest zajęte w 99% czasu trwania zadania. Klastr Ceph, cel, obciążenie z zadań kopii zapasowych Veeam jest lekkie. Klastry Ceph są zajęte tylko w 6% do 1% czasu pracy.

W porównaniu do poprzedniego testu, wydajność procesowania kopii zapasowej maszyny wirtualnej jest znacznie niższa niż kopii zapasowej na dysku SSD.To głównie dlatego, że dane maszyny wirtualnej są przechowywane na dysku twardym.

Tabela 3.

| Rozmiar dysku (HDD) | 127GB |

| Odczyt danych ze źródła | 37.9GB |

| Dane przesłane do Ceph po Deduplikacji i Kompresji | 21,4GB |

| Deduplikacja | 3,3X |

| Kompresja | 1,8X |

Tabela 4. Tworzenie kopii obrazu maszyny wirtualnej na dysku SATA3 HDD

|

Kopia zapasowa Repozytorium |

Czas trwania (sek) |

Źródło (%) |

Serwer pośredniczący (%) |

Sieć (%) |

Docelowy (%) |

Przetwarzanie Szybkość (MB/s) |

Średnia Zapis danych Szybkość (MB/s) |

|

Linux VM, Wolumin RBD, EC | 363 | 99 | 7 | 3 | 6 | 145 | 60 |

|

Linux VM, Wolumin CephFS, EC | 377 | 99 | 7 | 2 | 1 | 142 | 58.1 |

|

Serwer Linux, Wolumin RBD, EC | 375 | 99 | 6 | 2 | 2 | 140 | 58.4 |

Uwaga: Średnie wskaźniki zapisu danych są obliczane jako iloraz Przesłanych danych przez Czas trwania. Te wskaźniki reprezentują obciążenia klastra Ceph w tych zadaniach tworzenia kopii zapasowych.

(3)Kopia zapasowa wirtualnych maszyn na ESXi na dysku HDD

Ten test tworzy kopię zapasową maszyn wirtualnych CentOS 7 i Windows 10 działających na dysku HDD hosta VMWare ESXi 6.5 do repozytorium wspieranego przez Ceph RBD z ochroną kodu zatracania 4+2.

Tabela 5.

| Źródło | CentOS VM | Windows 10 VM |

| Rozmiar dysku (HDD) | 40GB | 32GB |

| Odczyt danych ze źródła | 1.8GB | 12.9GB |

| Dane przesłane do Ceph po Deduplikacji i Kompresji | 966MB | 7.7GB |

| Deduplikacja | 22.1X | 2.5X |

| Kompresja | 1.9X | 1.7X |

Tabela 6.

|

Kopia zapasowa Źródło |

Czas trwania (sek) |

Źródło (%) |

Serwer pośredniczący (%) |

Sieć (%) |

Docelowy (%) |

Przetwarzanie Szybkość (MB/s) |

Średnia Zapis danych Szybkość (MB/s) |

| CentOS 7 | 122 | 99 | 10 | 5 | 0 | 88 | 8 |

| Windows 10 | 244 | 99 | 11 | 5 | 1 | 93 | 32 |

Uwaga: Średnie wskaźniki zapisu danych są obliczane jako iloraz Przesłanych danych przez Czas trwania. Te wskaźniki reprezentują obciążenia klastra Ceph w tych zadaniach tworzenia kopii zapasowych.

Wnioski

Według wyników testów, Ceph RBD i CephFS mają podobną wydajność. To odpowiada naszemu doświadczeniu dotyczącemu wydajności RBD i CephFS. Porównując cechy CephFS i RBD, mają swoje zalety i wady. Jeśli potrzebujesz wdrożyć wiele serwerów repozytorium, musisz utworzyć obraz RBD dla każdego serwera repozytorium kopii zapasowej, ponieważ można zamontować tylko jedno RBD Ceph na jednym hoście. W porównaniu do CephFS, korzystanie z RBD jest prostsze, ponieważ nie wymaga serwerów metadanych. Musimy przypisać rozmiar pojemności RBD podczas tworzenia, więc musisz zmienić jej rozmiar, gdy potrzebujesz więcej miejsca.

Jeśli używasz CephFS jako repozytorium, musisz wdrożyć co najmniej jeden serwer metadanych (MDS) w klastrze Ceph. Potrzebujemy również zapasowego serwera metadanych dla wysokiej dostępności. W porównaniu do Ceph RBD, nie musisz przypisywać systemowi plików limitu. Możesz traktować CephFS jako nieograniczone źródło pamięci.

W tej demonstracji przypadku użycia, nasze testy tworzą kopię zapasową tylko jednej maszyny w każdym zadaniu tworzenia kopii zapasowej. Zgodnie z powyższymi raportami testowymi, wiemy, że średnia szybkość zapisu danych jest związana z szybkością przetwarzania oraz efektywnością deduplikacji i kompresji danych. Szybszy dysk źródłowy skraca czas trwania zadania tworzenia kopii zapasowej i prowadzi do szybszej szybkości przetwarzania. W zależności od infrastruktury użytkowników, użytkownicy mogą wdrożyć kilka równoczesnych zadań, aby tworzyć kopie zapasowe różnych obiektów jednocześnie. Magazyn Ceph bardzo dobrze radzi sobie z obsługą wielu równoczesnych zadań.

Klastr Ceph z 20x dyskami HDD OSD zasilany przez 3x Ambedded Mars 400 może oferować do 700MB/s agregowanej przepustowości zapisu do puli kodu zatraty 4+2. Wdrażanie wielu bieżących zadań kopii zapasowych przynosi korzyść w postaci skrócenia całkowitego czasu trwania kopii zapasowej. Maksymalna wydajność klastra Ceph jest prawie liniowo proporcjonalna do całkowitej liczby dysków w klastrze.

W tym przypadku nie testowaliśmy użycia magazynu obiektowego S3 jako repozytorium kopii zapasowej. Magazyn obiektowy S3 może być używany jako warstwa pojemności w repozytorium kopii zapasowej Veeam Scale-Out oraz jako repozytorium archiwum docelowego dla kopii zapasowej NAS. Można łatwo skonfigurować bramę RADOS i tworzyć użytkowników magazynu obiektowego za pomocą Ambedded UVS manager, interfejsu graficznego zarządzania Ceph.

- Pobierz

Użyj Ceph jako repozytorium dla dokumentu technicznego Veeam Backup & Replication

Jak skonfigurować blok urządzenia Ceph RBD i system plików CephFS jako repozytorium kopii zapasowej Veeam do tworzenia kopii zapasowych maszyn wirtualnych...

Ściągnij- Powiązane produkty

Urządzenie pamięci masowej Ceph Mars 400PRO

Mars 400PRO

Mars 400 Ceph Appliance został zaprojektowany, aby sprostać wysokim potrzebom przechowywania danych w chmurze o dużej pojemności. Wykorzystuje dysk...

Detale