Distribuované úložiště

Můžete použít Ceph k vytvoření serverového clusteru pro ukládání dat s vysokou dostupností. Data jsou distribuována a replikována nebo rozdělena na kódy a uložena na zařízeních, která patří do různých předdefinovaných oblastí selhání. Ceph dokáže udržovat své datové služby bez ztráty dat i při selhání více zařízení, serverových uzlů, racků nebo lokalit najednou.

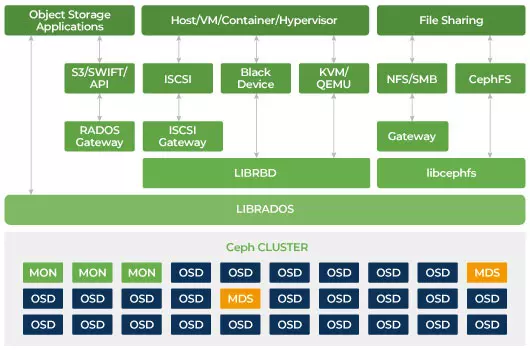

Softwarově definované úložiště Ceph

Klienti přímo interagují se všemi úložnými zařízeními pro čtení a zápis pomocí distribuovaného úložného algoritmu CRUSH od Cephu. Díky tomu eliminuje úzké hrdlo na tradičním adaptéru sběrnice hostitele (HBA), který omezuje škálovatelnost úložného systému. Ceph může lineárně škálovat svou kapacitu s výkonem až na exabajtovou úroveň.

Ceph je navržen tak, aby byl škálovatelný a neměl žádný jediný bod selhání. Monitor (MON), Object Storage Daemon (OSD) a Metadata Servers (MDS) jsou tři klíčové démony (Linuxové procesy) v Ceph clusteru. Obvykle bude mít Ceph cluster tři nebo více monitorovacích uzlů pro zajištění redundance. Monitory udržují hlavní kopii map clusteru, které umožňují Ceph klientům komunikovat přímo s OSD a MDS. Tyto mapy jsou kritickým stavem shluků, který je potřebný pro koordinaci démonů Ceph mezi sebou. Monitory jsou také zodpovědné za správu autentizace mezi démony a klienty. Lichá čísla monitorů udržují mapu clusteru pomocí kvóra. Tento algoritmus se vyhýbá jedinému bodu selhání na monitoru a zaručuje, že jejich konsensus je platný. OSD je démon pro objektové úložiště pro Ceph. Ukládá data, zajišťuje replikaci dat, obnovu, vyvažování a poskytuje některé informace o monitorování Ceph Monitorů kontrolou ostatních OSD démonů pro srdeční tep. Každý úložný server spouští jeden nebo více démonů OSD, jeden na úložném zařízení. Pro zajištění redundance a vysoké dostupnosti je obvykle potřeba minimálně 3 OSD. Démon MDS spravuje metadáta související soubory uložené na Ceph File System a také koordinuje přístup k sdílenému Ceph Storage Clusteru. Můžete mít více aktivních MDS pro zálohu a vyvážení zátěže každého MDS. Budete potřebovat jeden nebo více serverů metadat (MDS) pouze tehdy, když chcete používat sdílený souborový systém.

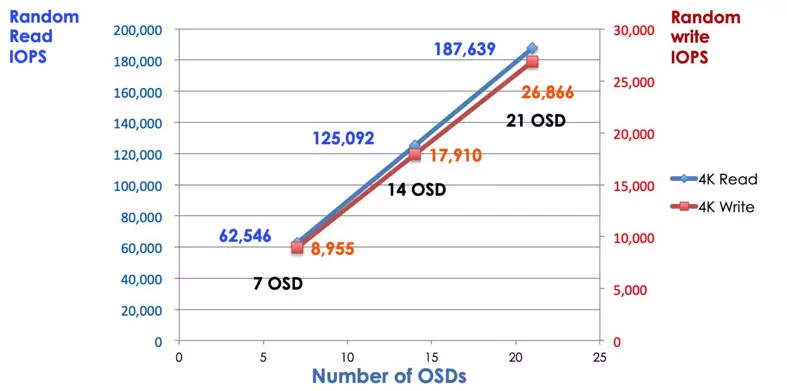

Ceph je škálovatelné úložiště

V tradičním úložném systému klienti komunikují s centralizovanou komponentou (např. hostitelským sběrnicovým adaptérem nebo bránou), která je jediným vstupním bodem do složitého podsystému. Centralizovaný řadič omezuje jak výkon, tak škálovatelnost a zavádí jediný bod selhání. Pokud se centrální komponenta zhroutí, celý systém se zhroutí také. Klienti Ceph získávají nejnovější mapu clusteru od monitorů a používají algoritmus CRUSH k výpočtu, který OSD v clusteru použít. Tento algoritmus umožňuje klientům přímo interagovat s Ceph OSD bez nutnosti procházet centrálním řadičem. Algoritmus CRUSH eliminuje jedinou cestu, která způsobuje omezení škálovatelnosti. Ceph OSD cluster poskytuje klientům sdílený úložný bazén. Když potřebujete více kapacity nebo výkonu, můžete přidat nový OSD pro rozšíření poolu. Výkon Ceph clusteru je lineárně proporcionální k počtu OSD. Následující obrázek ukazuje zvýšení čtení/zápisu IOPS, pokud zvýšíme počet OSD.

Tradiční diskové pole používá řadič RAID k ochraně dat před selháním disku. Kapacita pevného disku byla přibližně 20 MB, když byla vynalezena technologie RAID. Dnes je kapacita disku až 16TB. Čas potřebný k obnově selhání disku v RAID skupině může trvat týden. Během obnovy selhání řadiče RAID existuje šance, že by mohl současně selhat druhý disk. Pokud trvá obnova déle, pravděpodobnost ztráty dat je vyšší.

Ceph obnovuje data ztracená na selhání disku pomocí všech ostatních zdravých disků v clusteru. Ceph obnoví pouze data uložená na selhání disku. Pokud existuje více zdravých disků, doba obnovy bude kratší.

- Nastavte Ceph CRUSH Map & Pravidlo