تخزين موزع

يمكنك استخدام Ceph لبناء مجموعة خوادم لتخزين البيانات بطريقة عالية الاستقرار. يتم تخزين تكرارات البيانات أو شفرات الاستدراج بشكل موزع في الأجهزة التي تنتمي إلى مجالات فشل محددة مسبقًا. يمكن لـ Ceph الحفاظ على خدمة البيانات الخاصة بها دون فقدان البيانات عند فشل العديد من الأجهزة أو الخوادم أو الرفوف أو المواقع في نفس الوقت.

تخزين Ceph المعرف بالبرمجيات

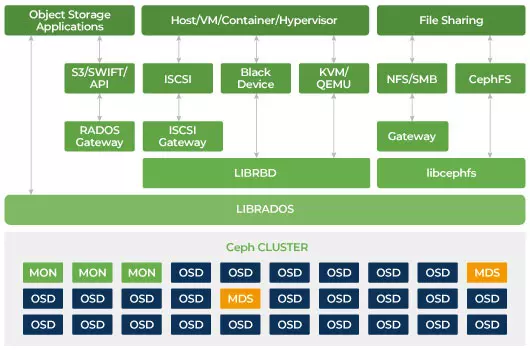

يتفاعل العملاء مباشرة مع جميع أجهزة التخزين للقراءة والكتابة باستخدام خوارزمية التخزين الموزعة CRUSH في Ceph. وبفضل ذلك، يتم القضاء على نقطة الضعف في محول الحافلة المضيفة التقليدي (HBA)، والذي يحد من قابلية توسعة نظام التخزين. يمكن لـ Ceph توسيع طاقتها بشكل خطي مع تحسين الأداء حتى مستوى الإكسابايت.

تم تصميم Ceph ليكون قابلاً للتوسع ولا يحتوي على نقطة فشل واحدة. المراقب (MON) وخادم تخزين الكائنات (OSD) وخوادم البيانات الوصفية (MDS) هي ثلاثة خدمات رئيسية (عمليات Linux) في مجموعة Ceph. عادةً، ستحتوي مجموعة Ceph على ثلاثة أو أكثر من أجهزة المراقبة لضمان الاحتياطية. تحافظ الشاشات على نسخة رئيسية من خرائط العنقود، مما يتيح لعملاء Ceph التواصل مباشرة مع OSD و MDS. هذه الخرائط هي حالة العنقود الحرجة المطلوبة لتنسيق مشروع Ceph مع بعضها البعض. تتولى الشاشات أيضًا مسؤولية إدارة المصادقة بين الخدمات والعملاء. الأعداد الفردية للشاشات تحتفظ بخريطة العنقود باستخدام الأغلبية. هذا الخوارزمية تجنب نقطة الفشل الوحيدة على الشاشة وتضمن أن اتفاقهم صحيح. OSD هو خادم التخزين الكائني لـ Ceph. يقوم بتخزين البيانات، ويتعامل مع استنساخ البيانات، واستعادتها، وإعادة توازنها، ويوفر بعض المعلومات المراقبة لمراقبي Ceph عن طريق فحص أجهزة OSD الأخرى للتأكد من وجود نبضة قلب. كل خادم تخزين يعمل بخادم OSD واحد أو أكثر، واحد لكل جهاز تخزين. عادة ما يكون هناك حاجة إلى 3 OSDs على الأقل للحصول على الاستعداد والتوفر العالي. يدير ديمون MDS البيانات الوصفية المتعلقة بالملفات المخزنة على نظام ملفات Ceph وينسق أيضًا الوصول إلى مجموعة تخزين Ceph المشتركة. يمكنك أن تمتلك عدة MDS نشطة لضمان الاحتياطية وتوازن حمولة كل MDS. ستحتاج إلى خادم واحد أو أكثر للبيانات الوصفية (MDS) فقط عندما ترغب في استخدام نظام الملفات المشترك.

تخزين Ceph قابل للتوسعة

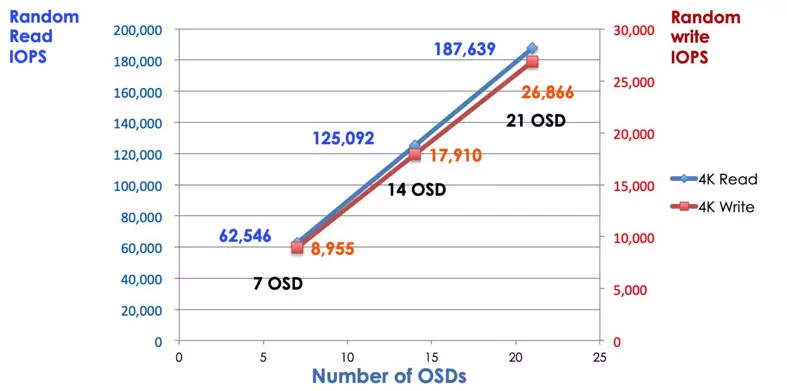

في نظام التخزين التقليدي، يتحدث العملاء إلى مكون مركزي (مثل محول الحافلة المضيفة أو البوابة)، وهو نقطة واحدة للدخول إلى نظام فرعي معقد. يفرض المراقب المركزي حدًا على الأداء والقابلية للتوسعة ويعرض نقطة فشل واحدة. إذا تعطل المكون المركزي، فإن النظام بأكمله سيتعطل أيضًا. يحصل عملاء Ceph على أحدث خريطة للمجموعة من المراقبين ويستخدمون خوارزمية CRUSH لحساب أي OSD في المجموعة. يتيح هذا الخوارزمية للعملاء التفاعل مع Ceph OSD مباشرة دون الحاجة إلى المرور عبر وحدة تحكم مركزية. تقنية CRUSH تقضي على المسار الواحد، مما يتسبب في تحديد قدرة التوسع. توفر مجموعة أقراص التخزين الموزعة لـ Ceph للعملاء مجموعة تخزين مشتركة. عندما تحتاج إلى مزيد من القدرة أو الأداء، يمكنك إضافة OSD جديد لتوسيع المجموعة. أداء مجموعة Ceph يتناسب خطيا مع عدد OSD. الصورة التالية توضح زيادة IOPS للقراءة/الكتابة إذا زدنا عدد OSD.

تستخدم مجموعة الأقراص التقليدية وحدة تحكم RAID لحماية البيانات من فشل القرص. كانت سعة قرص التخزين الصلب حوالي 20 ميجابايت عند اختراع تقنية RAID. اليوم سعة القرص بحجم 16 تيرابايت. قد يستغرق وقت إعادة بناء قرص فاشل في مجموعة RAID أسبوعًا. أثناء إعادة بناء وحدة تحكم RAID للقرص الفاشل، هناك فرصة لفشل قرص ثاني بشكل متزامن. إذا استغرقت عملية إعادة البناء وقتًا أطول، فإن احتمالية فقدان البيانات أعلى.

يقوم Ceph بإستعادة البيانات المفقودة في القرص الفاشل من خلال جميع الأقراص الصحية الأخرى في العنقود. سيقوم Ceph بإعادة بناء وإصلاح البيانات المخزنة في القرص الفاشل فقط. إذا كان هناك مزيد من الأقراص الصحية، سيكون وقت الاستعادة أقصر.

- تكوين خريطة Ceph CRUSH والقاعدة