Penyimpanan Terdistribusi

Anda dapat menggunakan Ceph untuk membangun kluster server untuk menyimpan data dengan ketersediaan tinggi. Replikasi data atau chunk kode penghapusan disimpan secara terdistribusi di perangkat yang termasuk dalam domain kegagalan yang telah ditentukan sebelumnya. Ceph dapat menjaga layanan datanya tanpa kehilangan data ketika beberapa perangkat, node server, rak, atau situs mengalami kegagalan pada saat yang bersamaan.

Penyimpanan Terdefinisi Perangkat Lunak Ceph

Klien berinteraksi langsung dengan semua perangkat penyimpanan untuk membaca dan menulis menggunakan algoritma penyimpanan terdistribusi CRUSH dari Ceph. Karena itu, ini menghilangkan bottleneck pada Host Bus Adaptor (HBA) tradisional, yang membatasi skalabilitas sistem penyimpanan. Ceph dapat meningkatkan kapasitasnya secara linear dengan kinerja hingga skala eksabyte.

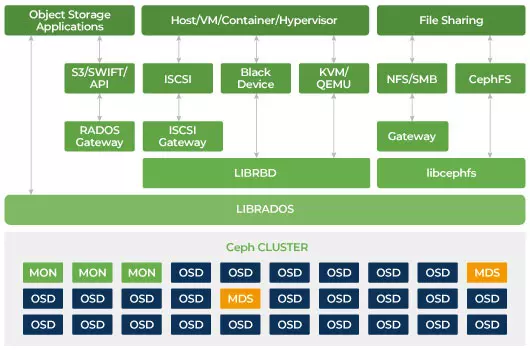

Ceph dirancang agar dapat diskalakan dan tidak memiliki titik kegagalan tunggal. Monitor (MON), Object Storage Daemon (OSD), dan Metadata Servers (MDS) adalah tiga daemon kunci (proses Linux) dalam klaster Ceph. Biasanya, sebuah klaster Ceph akan memiliki tiga atau lebih node pemantau untuk redundansi. Monitor menjaga salinan utama peta kluster, yang memungkinkan klien Ceph berkomunikasi langsung dengan OSD dan MDS. Peta-peta ini adalah keadaan klaster yang penting yang diperlukan oleh daemon Ceph untuk berkoordinasi satu sama lain. Monitor juga bertanggung jawab untuk mengelola autentikasi antara daemon dan klien. Jumlah monitor yang ganjil menjaga peta kluster menggunakan kuorum. Algoritma ini menghindari titik kegagalan tunggal pada monitor dan menjamin bahwa konsensus mereka valid. OSD adalah daemon penyimpanan objek untuk Ceph. Ini menyimpan data, menangani replikasi data, pemulihan, penyeimbangan ulang, dan memberikan beberapa informasi pemantauan kepada Ceph Monitors dengan memeriksa OSD Daemons lainnya untuk detak jantung. Setiap server penyimpanan menjalankan satu atau beberapa daemon OSD, satu perangkat penyimpanan. Setidaknya 3 OSD biasanya diperlukan untuk keberagaman dan ketersediaan tinggi. Daemon MDS mengelola metadata terkait file yang disimpan di Sistem File Ceph dan juga mengkoordinasikan akses ke Kluster Penyimpanan Ceph bersama. Anda dapat memiliki beberapa MDS aktif untuk keandalan dan menyeimbangkan beban setiap MDS. Anda akan membutuhkan satu atau lebih Metadata Server (MDS) hanya ketika Anda ingin menggunakan sistem file bersama.

Ceph adalah Penyimpanan yang Skalabel

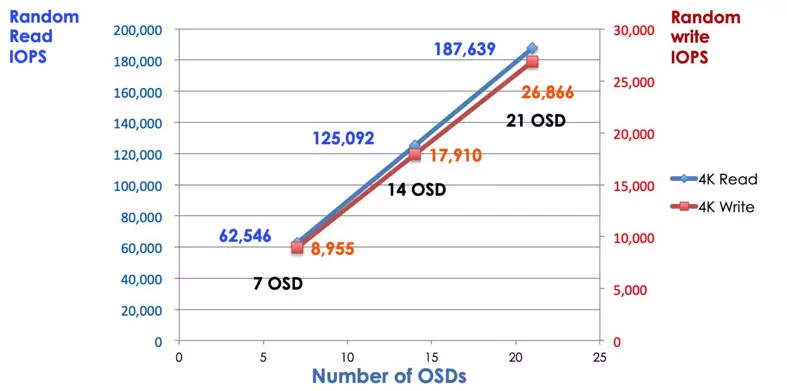

Dalam sistem penyimpanan tradisional, klien berbicara dengan komponen terpusat (misalnya, host bus adaptor atau gateway), yang merupakan titik masuk tunggal ke dalam subsistem yang kompleks. Kontroler terpusat memberlakukan batasan terhadap kinerja dan skalabilitas, serta memperkenalkan titik kegagalan tunggal. Jika komponen terpusat mati, seluruh sistem juga mati. Klien Ceph mendapatkan peta kluster terbaru dari monitor dan menggunakan algoritma CRUSH untuk menghitung OSD mana yang ada di kluster. Algoritma ini memungkinkan klien berinteraksi langsung dengan Ceph OSD tanpa melalui kontroler terpusat. Algoritma CRUSH menghilangkan jalur tunggal, yang menyebabkan keterbatasan skalabilitas. Klaster OSD Ceph menyediakan klien dengan kolam penyimpanan bersama. Ketika Anda membutuhkan kapasitas atau performa lebih, Anda dapat menambahkan OSD baru untuk memperluas pool. Kinerja klaster Ceph berbanding lurus dengan jumlah OSD. Gambar berikut menunjukkan peningkatan IOPS baca/tulis jika kita meningkatkan jumlah OSD.

Array disk tradisional menggunakan kontroler RAID untuk melindungi data dari kegagalan disk. Kapasitas hard disk drive sekitar 20MB ketika teknologi RAID ditemukan. Hari ini kapasitas disk sebesar 16TB. Waktu untuk membangun kembali disk yang gagal dalam grup RAID mungkin memakan waktu seminggu. Saat kontroler RAID sedang membangun kembali drive yang gagal, ada kemungkinan disk kedua juga bisa gagal secara bersamaan. Jika proses pemulihan memakan waktu lebih lama, kemungkinan kehilangan data lebih tinggi.

Ceph memulihkan data yang hilang pada disk yang gagal dengan menggunakan semua drive yang masih sehat dalam kluster. Ceph hanya akan memperbaiki data yang tersimpan pada drive yang gagal. Jika terdapat lebih banyak disk yang masih sehat, waktu pemulihan akan lebih singkat.

- Konfigurasi Peta CRUSH Ceph & Aturan